Штучний інтелект та велика політика: У тіні загроз - Чи необхідні регуляції?

Аналіз регуляцій ШІ в контексті глобальної політики, що досліджує баланс між інноваціями та питаннями безпеки.

Штучний інтелект та велика політика — У тіні загроз - Чи необхідні регуляції?

Ми живемо у час, коли технологія, медіа та політика переплетені і сильно впливають одне на одного. Однією з найновіших подій у цьому явищі є вибух штучного інтелекту (ШІ), особливо генеративного ШІ, який викликає революцію в багатьох сферах нашого життя — включаючи політику, економіку та культуру. Однак генеративний ШІ також викликав побоювання щодо його зловживання, особливо в політичному контексті.

Політичний ландшафт дедалі більше домінують соціальні мережі, які стали новою ареною для виборчих кампаній, пропаганди та масової мобілізації. Цифри говорять самі за себе: Statista оцінює, що до 2029 року в Китаї буде 1,2 мільярда користувачів соціальних мереж, в Індії — 1,3 мільярда, а в Нігерії — 114 мільйонів1 — ці країни представляють величезний електорат, який можна мобілізувати через цифрові платформи.

Користувачі соціальних мереж за країнами (2023-2029)

Чи необхідна регуляція в світлі зростаючих загроз від дипфейків, дезінформації та маніпуляцій? Чи достатньо існуючих законів? Чи не варто нам протистояти інноваціям, щоб не гальмувати прогрес? Ця стаття аналізує ці питання та розглядає приклади з різних частин світу.

Brexit: Політична сила соціальних мереж

Проте соціальні мережі також можуть бути джерелом дезінформації та психологічної маніпуляції. Найкращим прикладом цього є кампанія Brexit у Великій Британії (2016), де як кампанія «Leave», так і кампанія «Remain» використовували соціальні мережі для мобілізації прихильників. Дослідження Європейського парламенту показують, що кампанія «Leave» генерувала на 20% більше лайків та коментарів в Instagram, ніж кампанія «Remain»2. У Facebook різниця була ще більш драматичною — кампанія «Leave» досягла втричі більшого залучення (лайків, коментарів, поширень), ніж її опоненти.

Залученість до соціальних мереж кампанії Brexit

Цей приклад показує, як соціальні мережі можна використовувати для впливу на громадську думку та прийняття політичних рішень, які змінюють історію цілих націй. Це також породжує питання: чи були ці кампанії справедливими? І найголовніше: як ми можемо гарантувати, що майбутні кампанії не будуть скомпрометовані дезінформацією, психологічними маніпуляціями чи дипфейками?

Дипфейки та політика: Від наукової фантастики до реальності

Дипфейки є однією з найвидиміших загроз, пов'язаних з генеративним ШІ. Ця технологія дозволяє створювати надзвичайно реалістичні підроблені відео, аудіозаписи або зображення, які приписують людям слова чи дії, яких ніколи не було. У політичному контексті дипфейки можуть використовуватися для маніпулювання громадською думкою, дискредитації опонентів або створення хаосу та невизначеності.

Прикладом цього є звинувачення Дональда Трампа під час президентської кампанії 2024 року, що кампанія Камали Гарріс використовувала ШІ для зміни фотографій мітингів та збільшення кількості учасників3. Трамп стверджував, що фотографії були «підробленими» та створеними за допомогою ШІ. Це є прикладом того, як ШІ може використовуватися для посіву сумнівів та дискредитації опонентів — навіть якщо звинувачення безпідставні. Це також показує, що громадськість стає все більш обізнаною про можливості дипфейків та маніпуляцій ШІ.

Ще одним прикладом є дипфейкове відео від «Dor Brothers», яке показує світових лідерів (включаючи Джо Байдена, Володимира Путіна та Дональда Трампа), які грабують магазини4. Хоча це сатиричне відео, воно показує, наскільки легко стало створювати переконливі дипфейки, які можуть підірвати довіру до політиків та інституцій.

Дипфейки більше не є далеким майбутнім — вони вже реальність. І хоча технологія ще не ідеальна, вона швидко розвивається. Тож як ми можемо захиститися від цієї загрози?

Виявлення дипфейків: Боротьба проти дезінформації

Відповіддю на загрозу дипфейків є виявлення — технології, які можуть ідентифікувати та позначати дипфейки, щоб громадськість знала, що певне відео чи фото було маніпульоване. Агентство передових оборонних дослідницьких проектів (DARPA) у США проводить програму MediFor, яка розробляє технології для виявлення маніпуляцій у цифрових медіа5. Програма спрямована на створення інструментів, заснованих як на алгоритмах глибокого навчання, так і на криміналістичному аналізі зображень та відео.

У приватному секторі Facebook (Meta) запустив Deepfake Detection Challenge, публічне змагання, яке запросило дослідників розробляти алгоритми для виявлення дипфейків6. Виклик залучив сотні команд з усього світу та призвів до розробки інструментів, які тепер використовуються для боротьби з дезінформацією на платформах соціальних мереж.

Google також інвестує в дослідження виявлення дипфейків, надаючи набори даних та інструменти для дослідників для навчання моделей виявлення маніпульованих медіа7. Компанія також запустила ініціативу з освіти користувачів про ризики дипфейків та навчання їх розпізнавати підозрілий контент.

У приватному секторі McAfee запустив Deepfake Audio Detector у 2024 році, інструмент, який виявляє маніпульовані аудіозаписи з точністю 90%8. Це особливо важливо в контексті аудіодипфейків, які використовуються в шахрайстві, фішингу та політичних маніпуляціях.

Хоча ці зусилля обіцяючі, виявлення дипфейків є постійною гонкою між творцями та детекторами — як тільки розробляється алгоритм виявлення, творці дипфейків розробляють нові техніки для його обходу. Тож чи достатньо лише виявлення? Чи потрібні нам сильніші регуляції?

Ризики ШІ: Що каже наука

Массачусетський технологічний інститут (MIT) веде AI Risk Repository, всебічну базу даних ризиків ШІ, які варіюються від упередженості та дискримінації до дезінформації та екзистенційних загроз9. Репозиторій ідентифікує понад 700 ризиків ШІ, класифікованих за типом, серйозністю та ймовірністю виникнення. Однією з найбільших загроз є використання ШІ для маніпулювання громадською думкою та підриву демократичних процесів.

OpenAI, творець ChatGPT, опублікував GPT-4o System Card, який описує можливості та ризики найновішої моделі10. Картка показує, що GPT-4o може створювати переконливі політичні аргументи, які важко відрізнити від написаних людьми. Тести показали, що аргументи, згенеровані GPT-4o, були на 78% такими ж ефективними, як написані людьми, у переконанні людей у політичних питаннях.

Переконливість GPT-4o проти людей у політичних темах

Архітектура GAN (генеративно-змагальні мережі), на якій базується технологія дипфейків, була вперше описана Яном Гудфеллоу у 2014 році11. З тих пір технологія зробила значний прогрес, і сучасні GAN можуть створювати зображення, відео та аудіозаписи, які неможливо відрізнити людським оком та вухом. Це породжує питання: якщо технологія настільки просунута, як ми можемо її контролювати?

Регуляторне середовище для ШІ: Закони та ініціативи

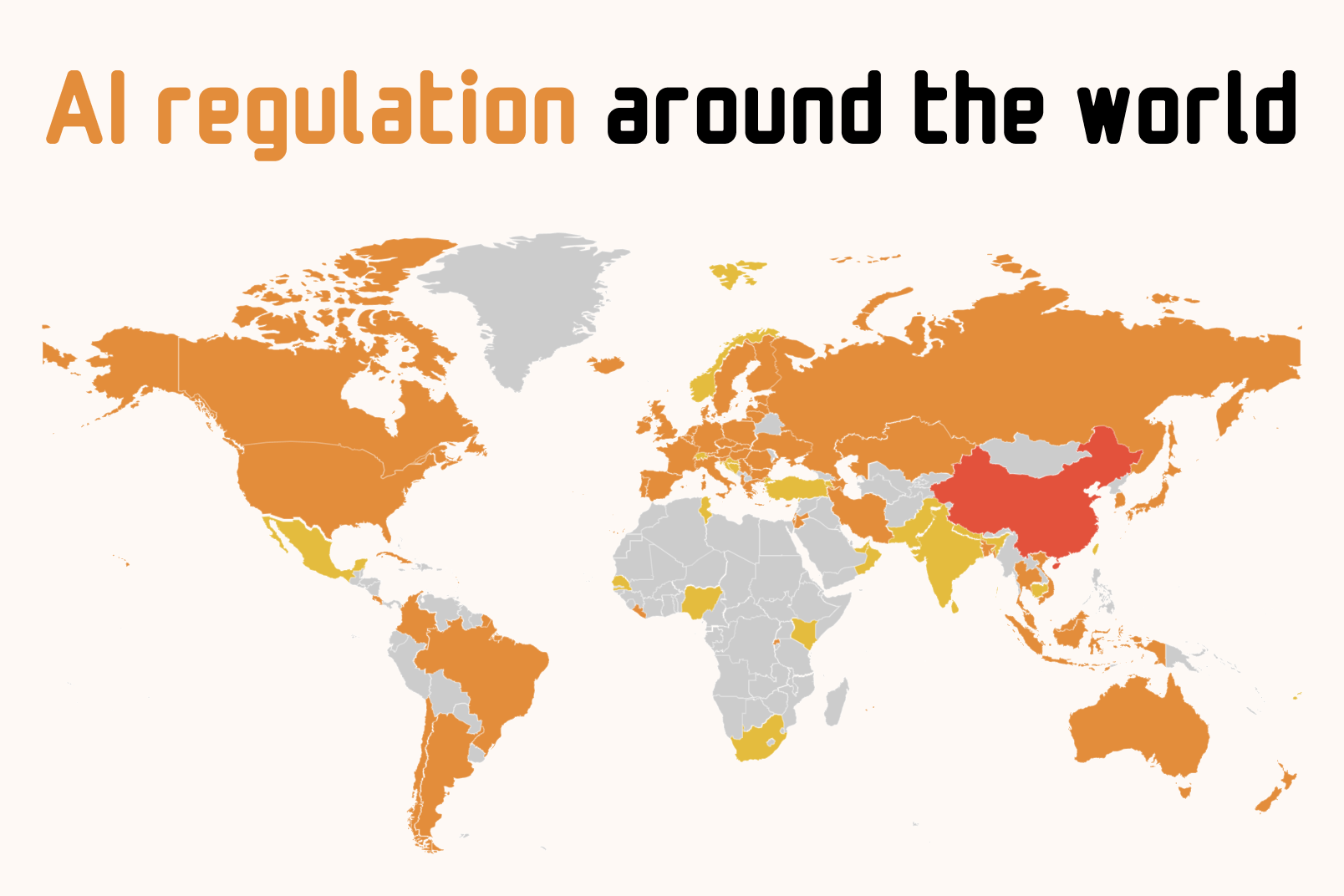

Закони явно відстають від технологій. Згідно з Lewis Silkin, юридичною фірмою, що відстежує глобальні регуляції ШІ, лише кілька країн запровадили комплексні закони для регулювання ШІ12. Більшість країн все ще перебувають на стадії консультацій або законодавства. Нижче наведена порівняльна таблиця регуляцій ШІ в різних країнах та регіонах:

Порівняння глобальних регуляцій ШІ

| Регіон/Країна | Регуляція | Рік | Ключові особливості | Статус |

|---|---|---|---|---|

| Європейський Союз | AI Act | 2024 | Підхід на основі ризиків, вимоги прозорості, маркування контенту ШІ | Активний |

| Бразилія | AI Law (Bill 2338/2023) | 2021 | Фокус на захист даних, правозастосування ANPD, обмеження тренувальних даних | Активний |

| США (Каліфорнія) | SB-1047 | 2024 | Вимоги безпеки для великих моделей ($100M+ обчислень), запобігання критичним загрозам | Запропоновано |

Європейський Союз був першою великою організацією, яка прийняла комплексну регуляцію ШІ — AI Act, який набув чинності у 2024 році13. Закон класифікує системи ШІ за рівнем ризику (від мінімального до неприйнятного) і встановлює вимоги щодо прозорості, тестування та маркування контенту ШІ. Закон також вимагає, щоб системи ШІ, які використовуються для маніпулювання громадською думкою, були класифіковані як «високий ризик» і підпорядковувалися суворому контролю.

Однак AI Act не обійшовся без суперечок. Meta (Facebook) та Spotify публічно критикували закон, стверджуючи, що він занадто обмежувальний і гальмує інновації14. Як наслідок, Meta оголосила про затримку випуску своєї моделі ШІ Llama в ЄС. Apple також оголосила про затримку впровадження функцій Apple Intelligence в ЄС через регуляторні побоювання15.

У Бразилії набув чинності закон про ШІ (Bill 2338/2023) у 2021 році, який зосереджується на захисті даних та етичному використанні ШІ16. Закон виконується Національним управлінням захисту даних (ANPD), яке може змусити компанії модифікувати або видалити системи ШІ, якщо вони порушують закони про конфіденційність. У 2024 році ANPD зупинила плани Meta використовувати пости в соціальних мережах для навчання ШІ, посилаючись на занепокоєння щодо конфіденційності17.

Human Rights Watch (HRW) виявила у 2024 році, що багато наборів даних для навчання ШІ містили особисті фотографії бразильських дітей без батьківської згоди18. Це породжує питання: як ми можемо гарантувати, що системи ШІ не порушують конфіденційність та безпеку вразливих груп?

У США Каліфорнія запропонувала Senate Bill 1047 (Safe and Secure Innovation for Frontier Artificial Intelligence Models Act) у 2024 році19. Закон би запровадив вимоги безпеки для великих моделей ШІ, які потребують понад 100 мільйонів доларів обчислювальних витрат. Закон також би вимагав, щоб компанії ШІ проводили плани реагування на інциденти та незалежні аудити.

Anthropic, творець Claude, підтримав закон з поправками20. Однак технологічні гіганти, такі як OpenAI, Google та Meta, виступили проти закону, стверджуючи, що він занадто дорогий та бюрократичний21. Закон був зрештою відхилений губернатором Каліфорнії Гевіном Ньюсомом.

Висновок: Регуляція проти інновацій — Де баланс?

Чи необхідна регуляція? Відповідь складна. З одного боку, дипфейки, дезінформація та маніпуляції становлять реальну загрозу для демократії та громадської безпеки. Без належної регуляції ШІ може використовуватися для підриву демократичних процесів, дискредитації політиків та створення хаосу й невизначеності.

З іншого боку, надмірна регуляція може загальмувати інновації та перешкодити компаніям розробляти нові технології, які можуть принести користь суспільству. Приклад Європейського Союзу показує, що занадто обмежувальні регуляції можуть призвести до того, що компанії вирішать не запускати свої продукти, що може загальмувати розвиток індустрії ШІ в регіоні.

Рішення, ймовірно, полягає в балансі — регуляції, які достатньо суворі, щоб захистити від реальних загроз, але достатньо гнучкі, щоб не гальмувати інновації. Також важливо, щоб регуляції базувалися на доказах і ґрунтувалися на поточних даних та дослідженнях, а не на страхах та спекуляціях.

Одне точно: ШІ нікуди не зникне, і його вплив на політику, економіку та культуру лише зростатиме. Наша відповідальність — як суспільства, як політиків і як громадян — гарантувати, що ШІ використовується таким чином, який приносить користь людству, а не шкодить йому. Регуляція — це інструмент, який може допомогти в цьому — але це не єдиний інструмент. Освіта, обізнаність та громадський діалог такі ж важливі, якщо не більш важливі.

Ми стоїмо на роздоріжжі. Ми можемо вибрати боятися ШІ та обмежувати його — або розуміти його та використовувати на благо людства. Який шлях ми виберемо, залежить від нас. Але одне точно: ми не можемо дозволити собі нічого не робити. Час діяти — зараз.

Джерела

- ↑ Number of social media users in selected countries in 2023 and 2029

- ↑ The impact of disinformation on democratic processes and human rights: Brexit case study

- ↑ Trump falsely claims Harris crowd photos were AI-generated

- ↑ Deepfake video showing world leaders robbing stores

- ↑ DARPA Media Forensics (MediFor) Program

- ↑ Facebook Deepfake Detection Challenge

- ↑ Google's Deepfake Detection Research

- ↑ McAfee launches Deepfake Audio Detector

- ↑ MIT AI Risk Repository: A Comprehensive Database of AI Risks

- ↑ GPT-4o System Card

- ↑ Generative Adversarial Networks: A Survey and Taxonomy

- ↑ AI regulation around the world

- ↑ Regulation (EU) 2024/1689 on Artificial Intelligence

- ↑ Meta delays EU release of Llama AI model over regulatory concerns

- ↑ Apple to delay AI features in EU over regulatory concerns

- ↑ Brazil's Artificial Intelligence Bill

- ↑ Brazil halts Meta's plans to use social media posts for AI training

- ↑ How AI Can Harm Children's Privacy and Safety

- ↑ California Senate Bill 1047: Safe and Secure Innovation for Frontier Artificial Intelligence Models Act

- ↑ Anthropic's letter supporting California SB 1047 with amendments

- ↑ Tech giants oppose California AI safety bill