Künstliche Intelligenz und große Politik: Im Schatten der Bedrohungen - Sind Regelungen notwendig?

Eine Analyse der KI-Regulierungen im Kontext der globalen Politik, die die Balance zwischen Innovation und Sicherheitsbedenken untersucht.

Künstliche Intelligenz und große Politik — Im Schatten der Bedrohungen - Sind Regelungen notwendig?

Wir leben in einer Zeit, in der Technologie, Medien und Politik miteinander verflochten sind und sich gegenseitig stark beeinflussen. Eine der neuesten Entwicklungen in diesem Phänomen ist die Explosion künstlicher Intelligenz (KI), insbesondere generativer KI, die in vielen Bereichen unseres Lebens eine Revolution auslöst — darunter Politik, Wirtschaft und Kultur. Generative KI hat jedoch auch Ängste vor ihrem Missbrauch geweckt, insbesondere im politischen Kontext.

Die politische Landschaft wird zunehmend von sozialen Medien dominiert, die zur neuen Arena für Wahlkämpfe, Propaganda und Massenmobilisierung geworden sind. Die Zahlen sprechen für sich: Statista schätzt, dass bis 2029 China 1,2 Milliarden Nutzer sozialer Medien haben wird, Indien 1,3 Milliarden und Nigeria 114 Millionen1 — diese Länder repräsentieren eine enorme Wählerschaft, die über digitale Plattformen mobilisiert werden kann.

Social-Media-Nutzer nach Ländern (2023-2029)

Ist angesichts der wachsenden Bedrohungen durch Deepfakes, Desinformation und Manipulation eine Regulierung notwendig? Sind bestehende Gesetze ausreichend? Oder sollten wir uns der Innovation nicht widersetzen, um den Fortschritt nicht zu bremsen? Dieser Artikel analysiert diese Fragen und betrachtet Beispiele aus verschiedenen Teilen der Welt.

Brexit: Die politische Macht sozialer Medien

Soziale Medien können jedoch auch eine Quelle von Desinformation und psychologischer Manipulation sein. Das beste Beispiel dafür ist die Brexit-Kampagne im Vereinigten Königreich (2016), wo sowohl die „Leave"- als auch die „Remain"-Kampagnen soziale Medien nutzten, um Anhänger zu mobilisieren. Studien des Europäischen Parlaments zeigen, dass die „Leave"-Kampagne auf Instagram 20 % mehr Likes und Kommentare generierte als die „Remain"-Kampagne2. Auf Facebook war der Unterschied noch drastischer — die „Leave"-Kampagne erzielte dreimal so viel Engagement (Likes, Kommentare, Shares) wie ihre Gegner.

Brexit-Kampagne Social-Media-Engagement

Dieses Beispiel zeigt, wie soziale Medien genutzt werden können, um die öffentliche Meinung zu beeinflussen und politische Entscheidungen zu treffen, die die Geschichte ganzer Nationen verändern. Es wirft auch die Frage auf: Waren diese Kampagnen fair? Und vor allem: Wie können wir sicherstellen, dass künftige Kampagnen nicht durch Desinformation, psychologische Manipulation oder Deepfakes gefährdet werden?

Deepfakes und Politik: Von der Science-Fiction zur Realität

Deepfakes sind eine der sichtbarsten Bedrohungen, die mit generativer KI verbunden sind. Diese Technologie ermöglicht es, äußerst realistische gefälschte Videos, Audioaufnahmen oder Bilder zu erstellen, die Menschen Worte oder Handlungen zuschreiben, die nie stattgefunden haben. Im politischen Kontext können Deepfakes zur Manipulation der öffentlichen Meinung, zur Diskreditierung von Gegnern oder zur Erzeugung von Chaos und Unsicherheit genutzt werden.

Ein Beispiel dafür ist die Anschuldigung von Donald Trump während der Präsidentschaftswahlkampagne 2024, dass die Kampagne von Kamala Harris KI verwendete, um Fotos von Kundgebungen zu ändern und die Teilnehmerzahlen zu vergrößern3. Trump behauptete, die Fotos seien „gefälscht" und mit KI erstellt worden. Dies ist ein Beispiel dafür, wie KI genutzt werden kann, um Zweifel zu säen und Gegner zu diskreditieren — selbst wenn die Anschuldigungen unbegründet sind. Es zeigt auch, dass die Öffentlichkeit zunehmend auf die Möglichkeiten von Deepfakes und KI-Manipulation sensibilisiert wird.

Ein weiteres Beispiel ist ein Deepfake-Video der „Dor Brothers", das Weltführer (darunter Joe Biden, Vladimir Putin und Donald Trump) beim Ladendiebstahl zeigt4. Obwohl es satirisch ist, zeigt dieses Video, wie einfach es geworden ist, überzeugende Deepfakes zu erstellen, die das Vertrauen in Politiker und Institutionen untergraben können.

Deepfakes sind keine ferne Zukunft mehr — sie sind bereits Realität. Und obwohl die Technologie noch nicht perfekt ist, entwickelt sie sich schnell weiter. Wie können wir uns also gegen diese Bedrohung schützen?

Deepfake-Erkennung: Der Kampf gegen Desinformation

Die Antwort auf die Deepfake-Bedrohung ist die Erkennung — Technologien, die Deepfakes identifizieren und kennzeichnen können, damit die Öffentlichkeit weiß, dass ein bestimmtes Video oder Foto manipuliert wurde. Die Defense Advanced Research Projects Agency (DARPA) in den USA führt das MediFor-Programm durch, das Technologien zur Erkennung von Manipulationen in digitalen Medien entwickelt5. Das Programm zielt darauf ab, Werkzeuge zu schaffen, die sowohl auf Deep-Learning-Algorithmen als auch auf forensischen Analysen von Bildern und Videos basieren.

Im Privatsektor hat Facebook (Meta) die Deepfake Detection Challenge ins Leben gerufen, einen öffentlichen Wettbewerb, der Forscher dazu einlud, Algorithmen zur Erkennung von Deepfakes zu entwickeln6. Die Herausforderung zog Hunderte von Teams aus der ganzen Welt an und führte zur Entwicklung von Werkzeugen, die jetzt zur Bekämpfung von Desinformation auf Social-Media-Plattformen eingesetzt werden.

Google investiert ebenfalls in Deepfake-Erkennungsforschung, indem es Datensätze und Werkzeuge für Forscher bereitstellt, um Modelle zur Erkennung manipulierter Medien zu trainieren7. Das Unternehmen hat auch eine Initiative ins Leben gerufen, um Nutzer über die Risiken von Deepfakes aufzuklären und ihnen beizubringen, wie man verdächtigen Inhalt erkennt.

Im privaten Sektor hat McAfee 2024 den Deepfake Audio Detector auf den Markt gebracht, ein Werkzeug, das manipulierte Audioaufnahmen mit 90 %iger Genauigkeit erkennt8. Das ist besonders wichtig im Kontext von Audio-Deepfakes, die in Betrügereien, Phishing und politischer Manipulation eingesetzt werden.

Obwohl diese Bemühungen vielversprechend sind, ist die Deepfake-Erkennung ein ständiger Wettlauf zwischen Schöpfern und Detektoren — sobald ein Erkennungsalgorithmus entwickelt wird, entwickeln Deepfake-Schöpfer neue Techniken, um ihn zu umgehen. Ist die Erkennung allein also ausreichend? Oder brauchen wir stärkere Regulierungen?

KI-Risiken: Was die Forschung sagt

Das Massachusetts Institute of Technology (MIT) führt das AI Risk Repository, eine umfassende Datenbank von KI-Risiken, die von Voreingenommenheit und Diskriminierung über Desinformation bis hin zu existenziellen Bedrohungen reichen9. Das Repository identifiziert über 700 KI-Risiken, kategorisiert nach Typ, Schweregrad und Wahrscheinlichkeit des Auftretens. Eine der größten Bedrohungen ist die Nutzung von KI zur Manipulation der öffentlichen Meinung und Untergrabung demokratischer Prozesse.

OpenAI, der Schöpfer von ChatGPT, hat die GPT-4o System Card veröffentlicht, die die Fähigkeiten und Risiken des neuesten Modells beschreibt10. Die Karte zeigt, dass GPT-4o überzeugende politische Argumente erstellen kann, die schwer von von Menschen geschriebenen zu unterscheiden sind. Tests zeigten, dass GPT-4o-generierte Argumente 78 % so effektiv wie menschengeschriebene waren bei der Überzeugung von Menschen in politischen Fragen.

GPT-4o vs menschliche Überzeugungskraft in politischen Themen

Die GANs-Architektur (Generative Adversarial Networks), auf der Deepfake-Technologie basiert, wurde erstmals 2014 von Ian Goodfellow beschrieben11. Seitdem hat die Technologie erhebliche Fortschritte gemacht, und heutige GANs können Bilder, Videos und Audioaufnahmen erstellen, die für das menschliche Auge und Ohr ununterscheidbar sind. Das wirft die Frage auf: Wenn die Technologie so fortschrittlich ist, wie können wir sie dann kontrollieren?

Das regulatorische Umfeld für KI: Gesetze und Initiativen

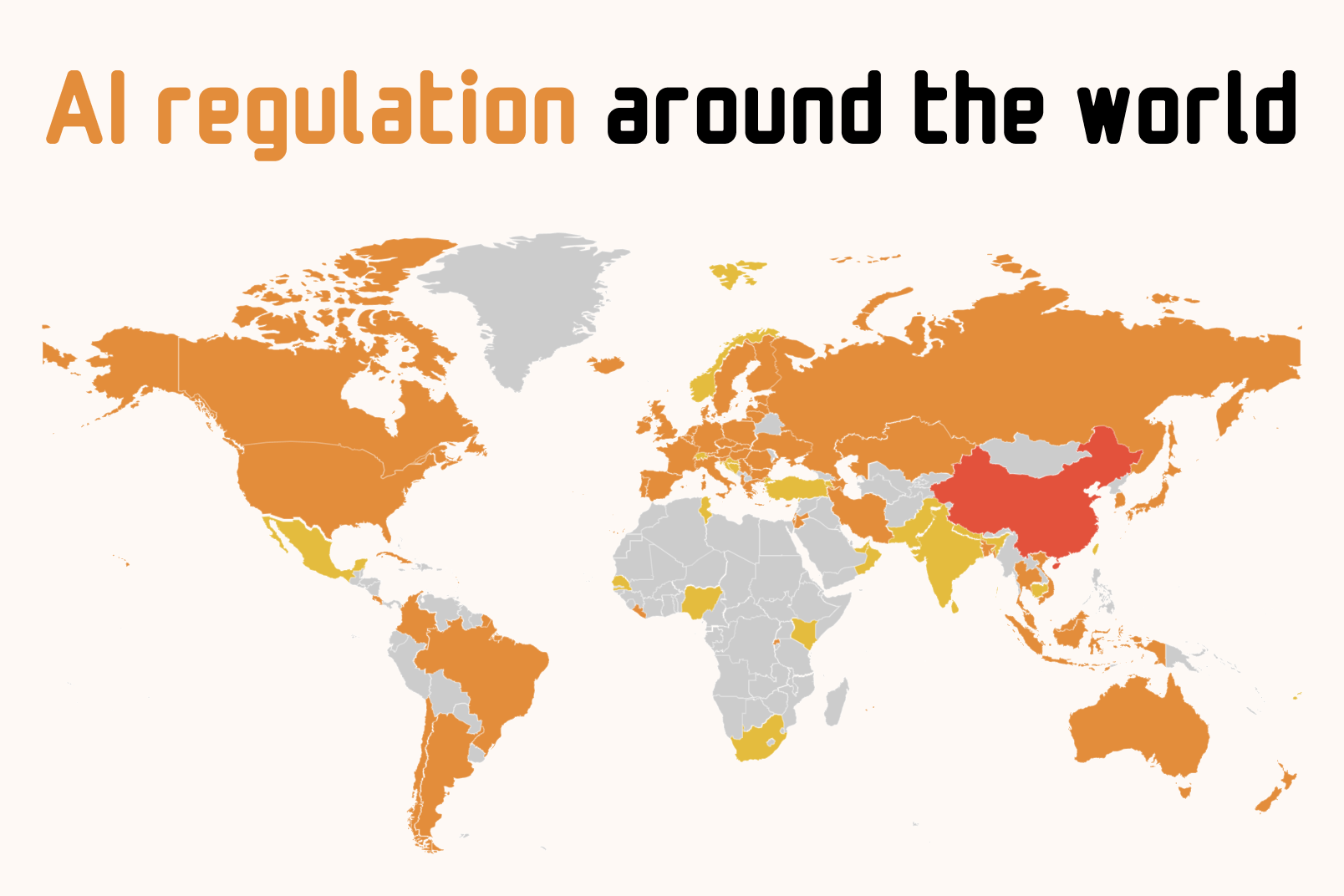

Gesetze hinken der Technologie eindeutig hinterher. Laut Lewis Silkin, einer Anwaltskanzlei, die globale KI-Regulierungen verfolgt, haben nur wenige Länder umfassende Gesetze zur Regulierung von KI eingeführt12. Die meisten Länder befinden sich noch in der Konsultations- oder Gesetzgebungsphase. Nachfolgend finden Sie eine Vergleichstabelle der KI-Regulierungen in verschiedenen Ländern und Regionen:

Vergleich globaler KI-Vorschriften

| Region/Land | Regulierung | Jahr | Hauptmerkmale | Status |

|---|---|---|---|---|

| Europäische Union | AI Act | 2024 | Risikobasierter Rahmen, Transparenzanforderungen, KI-Inhalte kennzeichnen | Aktiv |

| Brasilien | AI Law (Bill 2338/2023) | 2021 | Fokus auf Datenschutz, ANPD-Durchsetzung, Einschränkungen bei Trainingsdaten | Aktiv |

| USA (Kalifornien) | SB-1047 | 2024 | Sicherheitsanforderungen für große Modelle ($100M+ Rechenleistung), Verhinderung kritischer Schäden | Vorgeschlagen |

Die Europäische Union war die erste große Einheit, die umfassende KI-Regulierung verabschiedete — den AI Act, der 2024 in Kraft trat13. Das Gesetz klassifiziert KI-Systeme nach Risikoniveau (von minimal bis inakzeptabel) und legt Anforderungen für Transparenz, Tests und Kennzeichnung von KI-Inhalten fest. Das Gesetz verlangt auch, dass KI-Systeme, die zur Manipulation der öffentlichen Meinung verwendet werden, als „hohes Risiko" gekennzeichnet werden und strengen Kontrollen unterliegen.

Jedoch war der AI Act nicht ohne Kontroversen. Meta (Facebook) und Spotify kritisierten das Gesetz öffentlich und argumentierten, dass es zu restriktiv sei und Innovationen behindere14. Infolgedessen kündigte Meta an, die Veröffentlichung seines Llama-KI-Modells in der EU zu verzögern. Apple kündigte ebenfalls an, die Einführung von Apple Intelligence-Funktionen in der EU aufgrund regulatorischer Bedenken zu verzögern15.

In Brasilien trat 2021 ein KI-Gesetz (Bill 2338/2023) in Kraft, das den Schwerpunkt auf Datenschutz und ethische Nutzung von KI legt16. Das Gesetz wurde von der Nationalen Datenschutzbehörde (ANPD) durchgesetzt, die Unternehmen verpflichten kann, KI-Systeme zu modifizieren oder zu entfernen, wenn sie Datenschutzgesetze verletzen. Im Jahr 2024 stoppte die ANPD die Pläne von Meta, Social-Media-Beiträge für das KI-Training zu verwenden, und berief sich auf Datenschutzbedenken17.

Human Rights Watch (HRW) enthüllte 2024, dass viele KI-Trainingsdatensätze persönliche Fotos brasilianischer Kinder ohne elterliche Zustimmung enthielten18. Dies wirft die Frage auf: Wie können wir sicherstellen, dass KI-Systeme nicht die Privatsphäre und Sicherheit gefährdeter Gruppen verletzen?

In den USA schlug Kalifornien 2024 den Senate Bill 1047 (Safe and Secure Innovation for Frontier Artificial Intelligence Models Act) vor19. Das Gesetz würde Sicherheitsanforderungen für große KI-Modelle einführen, die über 100 Millionen Dollar an Rechenkosten erfordern. Das Gesetz würde auch verlangen, dass KI-Unternehmen Vorfallpläne und unabhängige Audits durchführen.

Anthropic, der Schöpfer von Claude, unterstützte das Gesetz mit Änderungsanträgen20. Jedoch widersetzten sich Tech-Giganten wie OpenAI, Google und Meta dem Gesetz und argumentierten, dass es zu kostspielig und bürokratisch sei21. Das Gesetz wurde schließlich vom kalifornischen Gouverneur Gavin Newsom abgelehnt.

Fazit: Regulierung vs. Innovation — Wo ist die Balance?

Ist eine Regulierung notwendig? Die Antwort ist komplex. Einerseits stellen Deepfakes, Desinformation und Manipulation reale Bedrohungen für die Demokratie und die öffentliche Sicherheit dar. Ohne geeignete Regulierung könnte KI zur Untergrabung demokratischer Prozesse, zur Diskreditierung von Politikern und zur Erzeugung von Chaos und Unsicherheit genutzt werden.

Andererseits kann eine übermäßige Regulierung Innovationen bremsen und verhindern, dass Unternehmen neue Technologien entwickeln, die der Gesellschaft zugutekommen könnten. Das Beispiel der Europäischen Union zeigt, dass zu restriktive Regulierungen dazu führen können, dass Unternehmen sich entscheiden, ihre Produkte nicht einzuführen, was die Entwicklung der KI-Industrie in der Region behindern könnte.

Die Lösung liegt wahrscheinlich in der Balance — Regulierungen, die streng genug sind, um gegen reale Bedrohungen zu schützen, aber flexibel genug, um Innovationen nicht zu behindern. Es ist auch wichtig, dass Regulierungen evidenzbasiert sind und auf aktuellen Daten und Forschungen basieren, nicht auf Ängsten und Spekulationen.

Eine Sache ist sicher: KI ist hier, um zu bleiben, und ihre Auswirkungen auf Politik, Wirtschaft und Kultur werden nur zunehmen. Es ist unsere Verantwortung — als Gesellschaft, als Politiker und als Bürger — sicherzustellen, dass KI auf eine Weise genutzt wird, die der Menschheit zugutekommt, nicht ihr schadet. Regulierung ist ein Werkzeug, das dabei helfen kann — aber es ist nicht das einzige. Bildung, Bewusstsein und öffentlicher Dialog sind ebenso wichtig, wenn nicht sogar wichtiger.

Wir stehen am Scheideweg. Wir können uns entscheiden, KI zu fürchten und sie einzuschränken — oder sie zu verstehen und sie zum Wohle der Menschheit zu nutzen. Welchen Weg wir wählen, hängt von uns ab. Aber eines ist sicher: Wir können es uns nicht leisten, nichts zu tun. Die Zeit zum Handeln ist jetzt.

Quellen

- ↑ Number of social media users in selected countries in 2023 and 2029

- ↑ The impact of disinformation on democratic processes and human rights: Brexit case study

- ↑ Trump falsely claims Harris crowd photos were AI-generated

- ↑ Deepfake video showing world leaders robbing stores

- ↑ DARPA Media Forensics (MediFor) Program

- ↑ Facebook Deepfake Detection Challenge

- ↑ Google's Deepfake Detection Research

- ↑ McAfee launches Deepfake Audio Detector

- ↑ MIT AI Risk Repository: A Comprehensive Database of AI Risks

- ↑ GPT-4o System Card

- ↑ Generative Adversarial Networks: A Survey and Taxonomy

- ↑ AI regulation around the world

- ↑ Regulation (EU) 2024/1689 on Artificial Intelligence

- ↑ Meta delays EU release of Llama AI model over regulatory concerns

- ↑ Apple to delay AI features in EU over regulatory concerns

- ↑ Brazil's Artificial Intelligence Bill

- ↑ Brazil halts Meta's plans to use social media posts for AI training

- ↑ How AI Can Harm Children's Privacy and Safety

- ↑ California Senate Bill 1047: Safe and Secure Innovation for Frontier Artificial Intelligence Models Act

- ↑ Anthropic's letter supporting California SB 1047 with amendments

- ↑ Tech giants oppose California AI safety bill