Sztuczna inteligencja i wielka polityka: W cieniu zagrożeń - Czy regulacje są konieczne?

Analiza regulacji AI w kontekście polityki globalnej, badająca równowagę między innowacjami a kwestiami bezpieczeństwa.

Sztuczna inteligencja i wielka polityka — W cieniu zagrożeń. Czy regulacje są konieczne?

Żyjemy w czasach, w których technologia, media i polityka przeplatają się jak nigdy dotąd. Platformy takie jak Facebook, Twitter i Instagram stały się niezbędnymi narzędziami komunikacji politycznej. Politycy mogą komunikować się bezpośrednio z wyborcami, mobilizować poparcie i organizować kampanie za ich pośrednictwem. Wykres z Statista pokazuje ogromny odsetek populacji każdego kraju korzystającego z mediów społecznościowych na całym świecie1. W 2023 roku Chiny miały ponad miliard użytkowników mediów społecznościowych, co czyni je krajem z najwyższą liczbą użytkowników. Oczekuje się, że do 2029 roku liczba ta przekroczy 1,2 miliarda. Jednak Indie mają przejąć prowadzenie, osiągając 1,3 miliarda użytkowników do 2029 roku. Tymczasem liczba użytkowników mediów społecznościowych w Nigerii ma wzrosnąć z 47 milionów w 2023 roku do 114 milionów w 2029 roku, co oznacza wzrost o 142%. "Cyfrowy elektorat" jest zatem przyszłością dla polityków.

Użytkownicy mediów społecznościowych według krajów (2023-2029)

Brexit: Polityczna moc mediów społecznościowych

Jednak media społecznościowe mogą być również źródłem dezinformacji i fałszywych wiadomości, co stanowi poważne wyzwanie dla współczesnej demokracji. Problem ten staje się widoczny na przykład podczas nadchodzących wyborów prezydenckich w Stanach Zjednoczonych, gdzie kandydat republikański Donald Trump niedawno fałszywie oskarżył swoją główną rywalkę, Kamalę Harris, o użycie obrazów generowanych przez AI2 w celu sztucznego zwiększenia liczby uczestników jej wydarzeń.

Dyskusja o wpływie mediów społecznościowych na współczesną politykę jest niekompletna bez wspomnienia o intrygującej analizie studium przypadku z Europejskiej Służby Badań Parlamentarnych opublikowanej w 2019 roku3. Autorzy zbadali, jak emocje i media społecznościowe mogą wpływać na opinię publiczną i wyniki wyborów, szczególnie podczas Brexitu. Referendum w sprawie członkostwa Wielkiej Brytanii w Unii Europejskiej w 2016 roku było pierwszym "cyfrowym referendum". Obie kampanie — Leave i Remain — skupiły się na strategiach online, a media społecznościowe odegrały kluczową rolę w rozpowszechnianiu informacji. W tym czasie 41% brytyjskich użytkowników internetu otrzymywało wiadomości za pośrednictwem mediów społecznościowych, głównie z Facebooka (29%) i Twittera (12%). Podczas kampanii opublikowano prawie 15 000 artykułów związanych z referendum. Media koncentrowały się na różnych kwestiach, takich jak ekonomia, imigracja i zdrowie, ale ton relacji był często stronniczy i emocjonalny. Kampania Leave była bardziej skuteczna w mediach społecznościowych dzięki bardziej emocjonalnym przekazom. Tematy takie jak imigracja były często omawiane w negatywnym świetle, a liczba raportów potroiła się podczas 10-tygodniowej kampanii. Posty zwolenników Leave na Instagramie otrzymały o 26% więcej polubień i o 20% więcej komentarzy niż posty zwolenników Remain, a najbardziej aktywni użytkownicy prowadzili kampanię za Leave. Na Facebooku prawie połowa najbardziej angażujących stron była otwarcie pro-Brexit, generując ponad 11 milionów interakcji — trzy razy więcej niż strony pro-Remain. Zatem mechanizmy, dzięki którym platformy mediów społecznościowych wzmacniają pewne przekazy, mogą mieć rzeczywiste i czasami nieodwracalne konsekwencje.

Zaangażowanie w mediach społecznościowych kampanii Brexit

Deep Fake i dezinformacja

Wracając do nieuczciwych praktyk w przestrzeni wirtualnej, fake news to fałszywe lub częściowo fałszywe informacje publikowane online w celu wprowadzenia w błąd odbiorców. Ta metoda manipulacji jest często wykorzystywana dla korzyści finansowych lub politycznych. Niestety, ta praktyka jest toksyczna dla debaty publicznej i znacznie pogłębia polaryzację społeczną. Kolejnym "wynalazkiem" do fałszowania infosfery są tak zwane deep fake. Te syntetyczne media obejmują manipulowane lub generowane przez AI obrazy, filmy lub audio, aby stworzyć wysoce realistyczny, ale fundamentalnie fałszywy efekt. Deep fake wykorzystują techniki uczenia maszynowego, takie jak Generative Adversarial Networks (GAN)4, aby mapować i replikować mimikę twarzy, głos i ruchy osoby.

Podobnie jak fake news, ta technologia może być wykorzystywana do rozpowszechniania dezinformacji. W trzecim tygodniu sierpnia na platformie X5 (dawniej Twitter) pojawił się film @thedorbrothers, pokazujący znane wpływowe postacie, takie jak Joe Biden, Donald Trump, Kamala Harris, Mark Zuckerberg, a nawet papież Franciszek, rzekomo rabujący sklepy z bronią w ręku. Poziom realizmu tej produkcji jest imponujący, demonstrując obecne możliwości technologiczne w tej dziedzinie. Biorąc pod uwagę, że narzędzia do tworzenia takich materiałów są stale rozwijane i ulepszane, można powiedzieć, że w prawdopodobnie niedalekiej przyszłości fałszywe treści będą tak trudne do zidentyfikowania, prowadząc do chaosu informacyjnego i fal procesów sądowych lub innych form rezonansu społecznego, ponieważ oskarżenia oparte na fałszywych dowodach mogą dotyczyć każdego z nas. Jak bez podstawy prawnej można udowodnić, że nie popełniło się przestępstwa lub naruszenia?

Walka z deepfake przy użyciu AI

Ironicznie, AI jest również wykorzystywana w walce z fałszywymi treściami. Materiały deepfake, dzięki masowemu dostępowi do obrazów i filmów, są coraz powszechniejsze w mediach społecznościowych, co wymaga skutecznego wykrywania. W odpowiedzi, organizacje takie jak DARPA6, Facebook7, i Google prowadzą rozległe badania nad metodami wykrywania deepfake8 wykorzystując różne podejścia głębokiego uczenia, takie jak LSTM lub RNN.

Konkretnym przykładem innowacyjnego narzędzia wykrywającego jest Deepfake Detector McAfee, wydany w sierpniu 2024 roku9. To przełomowe narzędzie wykrywa audio deepfake, analizując dźwięk w filmach i strumieniach na platformach takich jak YouTube i X (dawniej Twitter), ostrzegając użytkowników o potencjalnych deepfake. Działa bezpośrednio na urządzeniach użytkowników, zapewniając prywatność, ale nie obsługuje treści chronionych DRM.

Twórcy AI przyznają ryzyko — Najnowsze raporty

W sierpniu 2024 roku Massachusetts Institute of Technology opublikował AI Risk Repository, bazę danych zawierającą ponad 700 zagrożeń związanych z AI10. To repozytorium, opracowane z 43 istniejących ram ryzyka i klasyfikacji, jest podzielone na trzy główne części: bazę danych ryzyka AI, szczegółowo opisującą ryzyka, cytaty i numery stron z oryginalnych źródeł; taksonomię przyczynową ryzyk AI, klasyfikującą ryzyka według przyczyny, czasu i występowania; oraz taksonomię dziedzinową ryzyk AI, dzielącą ryzyka na siedem głównych dziedzin i 23 poddziedziny, takie jak dezinformacja i prywatność. Ta kompilacja ma na celu zapewnienie przeglądu krajobrazu zagrożeń AI, z regularnie aktualizowanymi źródłami informacji i wspólnymi ramami referencyjnymi dla badaczy, programistów, firm, audytorów, decydentów i regulatorów.

W tym kontekście warto wspomnieć, że OpenAI niedawno wyraziło obawy dotyczące użytkowników rozwijających emocjonalne przywiązanie do nowego modelu ChatGPT-4o11. Dzięki swoim zaawansowanym możliwościom model generuje bardziej realistyczne odpowiedzi, prowadząc do sytuacji, w których użytkownicy mogą przypisywać mu ludzkie cechy i tworzyć z nim emocjonalne więzi. Firma zauważyła, że niektórzy użytkownicy używali języka sugerującego tworzenie więzi z modelem, co może powodować problemy zarówno dla jednostek, jak i społeczeństwa.

"Podczas wczesnych testów, w tym red teaming i wewnętrznych testów użytkowników, zaobserwowaliśmy, że użytkownicy używali języka, który może wskazywać na tworzenie połączeń z modelem. [...] Ludzka socjalizacja z modelem AI może powodować efekty przeniesienia na interakcje międzyludzkie. Na przykład użytkownicy mogą tworzyć relacje społeczne z AI, zmniejszając ich potrzebę interakcji międzyludzkich — potencjalnie korzystne dla samotnych osób, ale potencjalnie wpływające na zdrowe relacje. Przedłużona interakcja z modelem może wpłynąć na normy społeczne."

OpenAI ostrzega, że takie zachowanie może zmniejszyć potrzebę interakcji międzyludzkich i wpłynąć na zdrowe relacje. Dlatego firma planuje dalsze badania nad potencjalnymi skutkami emocjonalnego przywiązania do AI i sposobami jego ograniczenia.

Co ciekawe, raport firmy na temat GPT-4o ocenił również, jak artykuły i chatboty generowane przez nowy flagowy model wpłynęły na opinie uczestników na tematy polityczne11. Okazało się, że AI nie była bardziej przekonująca niż ludzie, ale w trzech z dwunastu przypadków AI była bardziej przekonująca. Badanie zbadało, jak klipy audio i interaktywne rozmowy generowane przez GPT-4o wpływają na preferencje polityczne uczestników. AI nie była bardziej przekonująca niż ludzie. Klipy audio AI miały 78% skuteczności klipów audio ludzkich, a rozmowy AI miały 65% skuteczności rozmów ludzkich. Tydzień po badaniu sprawdzono trwałość zmian opinii. Efekt rozmowy AI wyniósł 0,8%, a klipów audio -0,72%.

Przekonująca moc GPT-4o vs ludzie w tematach politycznych

Środowisko regulacyjne dla AI — Konieczne czy nie?

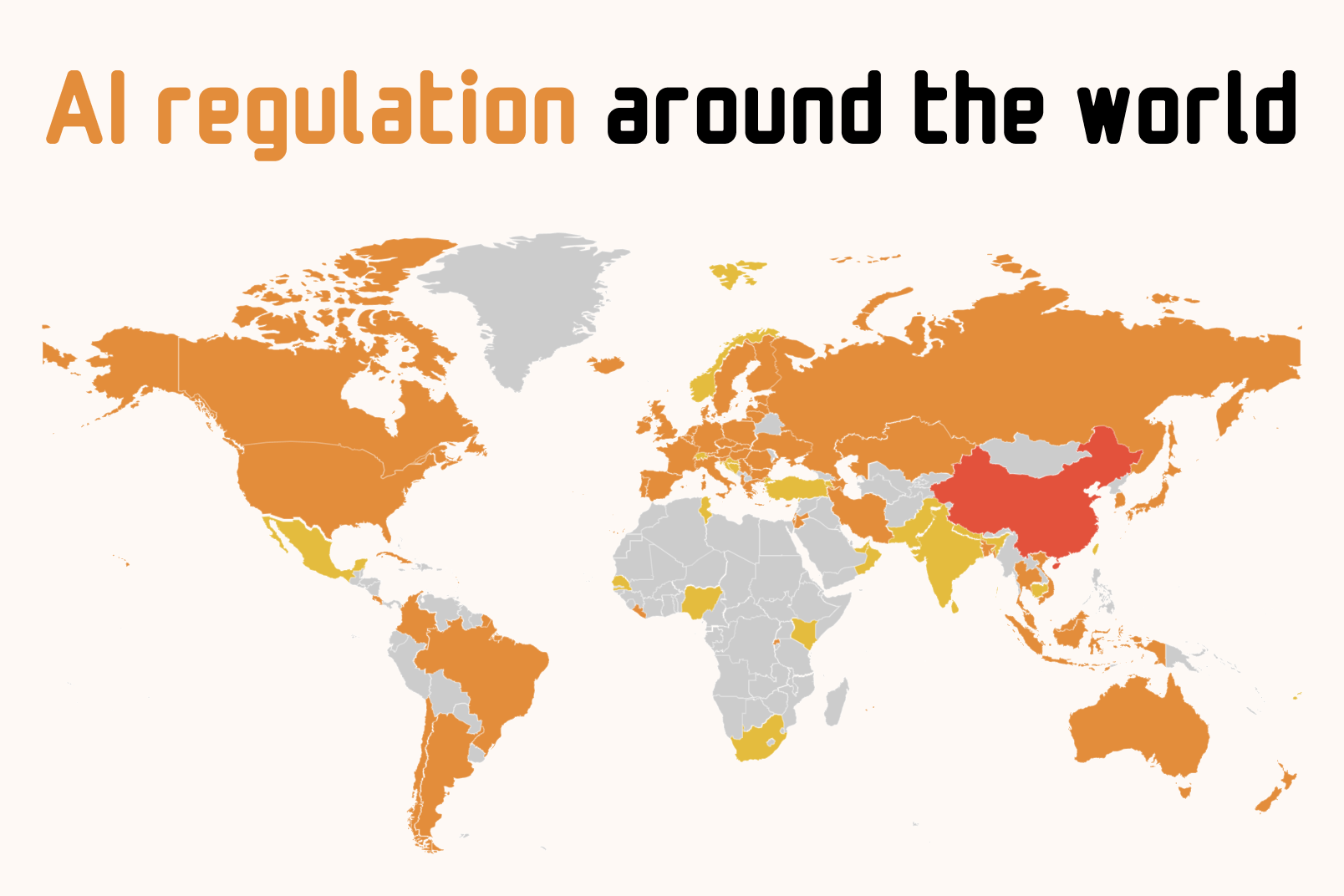

Prawo wyraźnie pozostaje w tyle za technologią. W cyberprzestrzeni przestępcy zaangażowani w różne nadużycia często pozostają nieuchwytni, co sprawia, że czują się "immunitetowi" na konsekwencje. W działalności przestępczej nowoczesne technologie, w tym sztuczna inteligencja, są coraz skuteczniej wykorzystywane, na przykład do kradzieży oszczędności osób lub pozyskiwania wrażliwych danych osobowych. Tak więc powstaje krytyczne pytanie o potrzebę regulacji prawnych w tym obszarze. Poniższa mapa pokazuje stanowisko krajów europejskich dotyczące wprowadzenia regulacji AI12 na poziomie krajowym.

Biorąc pod uwagę, że sami twórcy AI badają i wskazują ryzyka związane z jego użyciem, potrzeba regulacji prawnych wydaje się oczywista. Istotne pytanie pozostaje zakres tych regulacji.

Porównanie globalnych regulacji AI

| Region/Kraj | Regulacja | Rok | Kluczowe cechy | Status |

|---|---|---|---|---|

| Unia Europejska | AI Act | 2024 | Ramy oparte na ryzyku, wymagania przejrzystości, oznaczanie treści AI | Aktywny |

| Brazylia | AI Law (Bill 2338/2023) | 2021 | Skupienie na ochronie danych, egzekwowanie ANPD, ograniczenia danych treningowych | Aktywny |

| USA (Kalifornia) | SB-1047 | 2024 | Wymagania bezpieczeństwa dla dużych modeli ($100M+ obliczenia), zapobieganie krytycznym szkodom | Proponowany |

Unia Europejska była pierwszym dużym podmiotem, który wprowadził przepisy dotyczące sztucznej inteligencji. Tak zwany AI Act, opublikowany 12 lipca 2024 roku13, to dokument mający na celu ustanowienie zunifikowanych ram prawnych dla rozwoju, wdrażania i użytkowania systemów AI w UE. Dyrektywa zawiera kilka założeń mających na celu ochronę obywateli wspólnoty europejskiej. Zapewnia rozwijanie bezpiecznych i etycznych systemów AI szanujących prawa obywateli i nakazuje przejrzystość algorytmów oraz oznaczanie treści generowanych przez AI. Ponadto ustanawia zasady zarządzania całym cyklem życia systemu AI, od projektowania do użycia, i określa wytyczne wykorzystania AI dla sektora publicznego, w tym przez organy ścigania oraz w procesach wyborczych lub sądach. Warto zauważyć, że kompleksowa regulacja UE obejmuje również AI Act Compliance Checker, narzędzie pomocne dla małych i średnich przedsiębiorstw, a także startupów, do sprawdzania, czy ich systemy AI są zgodne z aktem UE. Obecnie to narzędzie jest w przygotowaniu.

Z drugiej strony, dokument przyjęty przez Parlament Europejski znacznie ogranicza postęp technologiczny Europy i pozbawia ją możliwości rozwijania nowoczesnych technologii na równym lub podobnym poziomie do innych kluczowych graczy na arenie międzynarodowej, takich jak Chiny czy USA. Dowodem może być niedawne ogłoszenie, że Meta nie planuje wprowadzić swojego multimodalnego modelu AI Llama 3.1 405B w Unii Europejskiej z powodu obaw regulacyjnych14. Wcześniej Apple podjęło podobną decyzję, wykluczając rynek UE z uruchomienia Apple Intelligence15.

Kolejnym przykładem organu regulacyjnego AI jest Brazylia, która już w 2021 roku zatwierdziła prawo AI16. Chociaż początkowo nie zapewniało wystarczającej przejrzystości, między innymi, brazylijscy prawodawcy pracują nad ulepszeniami. W lipcu 2024 roku brazylijska Narodowa Agencja Ochrony Danych (ANPD) nakazała Meta zaprzestać używania danych z Facebooka i Instagrama do trenowania swoich modeli AI17. Ta decyzja nastąpiła po raporcie Human Rights Watch pokazującym, że popularny zbiór danych używany do trenowania modeli AI zawierał zdjęcia brazylijskich dzieci18, stwarzając ryzyko ich wykorzystania w deepfake lub innych formach eksploatacji. Komentując tę kwestię, Meta stanowczo stwierdziła, że ich polityka "jest zgodna z brazylijskimi prawami i przepisami dotyczącymi prywatności", a decyzja ANPD jest "krokiem wstecz dla innowacji, konkurencji w rozwoju AI i dalszych opóźnień w dostarczaniu korzyści AI ludziom w Brazylii."

Pod koniec sierpnia 2024 roku Kalifornia również opublikowała projekt ustawy mającej na celu regulację najpotężniejszych modeli AI19. Ustawa wymaga od twórców modeli AI wykorzystujących zasoby obliczeniowe o wartości ponad 100 milionów dolarów przestrzegania i ujawniania planu bezpieczeństwa, aby zapobiec powodowaniu przez ich modele "krytycznej szkody". Jeśli zostanie przyjęta, może wzmocnić pozycję UE w regulowaniu AI i zainspirować inne stany do tworzenia własnych regulacji. Niektóre firmy, takie jak Anthropic, popierają ustawę po poprawkach20, a Elon Musk sugeruje jej uchwalenie. Jednak ustawa spotyka się również z szerokim sprzeciwem zarówno ze strony przemysłu, jak i Demokratów w Kongresie USA. Meta, OpenAI, Google i inne firmy sprzeciwiają się wprowadzeniu tej regulacji21, argumentując, że zaszkodzi rozwojowi oprogramowania open-source i innowacjom AI. Ustawa wymaga zatwierdzenia przez Zgromadzenie Ogólne do 31 sierpnia, następnie poparcia Senatu i podpisu gubernatora Kalifornii. Demokraci w Kongresie i Izba Handlowa USA wzywają Newsoma do weta ustawy.

To tylko kilka przykładów tego, jak globalne podmioty próbują "oprawić" sztuczną inteligencję w konteksty regulacyjne. Chociaż jesteśmy we wczesnej fazie tego procesu, można założyć, że kształtowanie środowiska prawnego dla AI będzie złożone, ponieważ musi uwzględniać tempo rozwoju tej technologii, które jest rzeczywiście imponujące.

Regulacje — Co dalej?

Każda nowa technologia niesie ze sobą zarówno możliwości, jak i zagrożenia. Sztuczna inteligencja służy jako cenny asystent w wielu branżach, ale korzyści z jej rozwoju muszą być zgodne z bezpieczeństwem. Identyfikacja ryzyka i środowisko prawne są równie ważne w tym przypadku. Wspomniany AI Act zapewnia użytkownikom — osobom, których dotyczy sztuczna inteligencja — obronę ich praw, gwarancje bezpieczeństwa i ramy regulacyjne dla jej użytkowania. Jednak spowolnienie lub naturalny rozwój technologii AI z powodu regulacji rynkowych to fakt. Europa pozbawia się suwerenności technologicznej i zwiększa lukę w porównaniu do globalnych graczy. Dyrektywa stanowi ograniczenia zarówno dla lokalnych producentów, jak i konsumentów i służy jako znaczące wyzwanie dla firm spoza UE, które nie będą mogły oferować swoich produktów i usług na jednym z największych rynków gospodarczych na świecie.

Podsumowując, chociaż ustanowienie ram regulacyjnych jest niezbędne dla właściwego funkcjonowania biznesu i społeczeństw w miarę ewolucji nowych technologii, wymaga zniuansowanego podejścia, które zapewnia komfort użytkownika, jednocześnie nie hamując postępu społecznego i gospodarczego. Ale czy możliwe jest zrównoważenie tych? Stworzenie optymalnego rozwiązania będzie znaczącym wyzwaniem, szczególnie biorąc pod uwagę dynamikę rozwoju AI. Istnieje rzeczywiście ryzyko, że podmioty, które zasadniczo nie priorytetyzują ochrony danych, na przykład, mogą zyskać taką przewagę w wyścigu technologicznym, że może się stać nieosiągalna.

Źródła

- ↑ Number of social media users in selected countries in 2023 and 2029

- ↑ Trump falsely claims Harris crowd photos were AI-generated

- ↑ The impact of disinformation on democratic processes and human rights: Brexit case study

- ↑ Generative Adversarial Networks: A Survey and Taxonomy

- ↑ Deepfake video showing world leaders robbing stores

- ↑ DARPA Media Forensics (MediFor) Program

- ↑ Facebook Deepfake Detection Challenge

- ↑ Google's Deepfake Detection Research

- ↑ McAfee launches Deepfake Audio Detector

- ↑ MIT AI Risk Repository: A Comprehensive Database of AI Risks

- ↑ GPT-4o System Card

- ↑ AI regulation around the world

- ↑ Regulation (EU) 2024/1689 on Artificial Intelligence

- ↑ Meta delays EU release of Llama AI model over regulatory concerns

- ↑ Apple to delay AI features in EU over regulatory concerns

- ↑ Brazil's Artificial Intelligence Bill

- ↑ Brazil halts Meta's plans to use social media posts for AI training

- ↑ How AI Can Harm Children's Privacy and Safety

- ↑ California Senate Bill 1047: Safe and Secure Innovation for Frontier Artificial Intelligence Models Act

- ↑ Anthropic's letter supporting California SB 1047 with amendments

- ↑ Tech giants oppose California AI safety bill