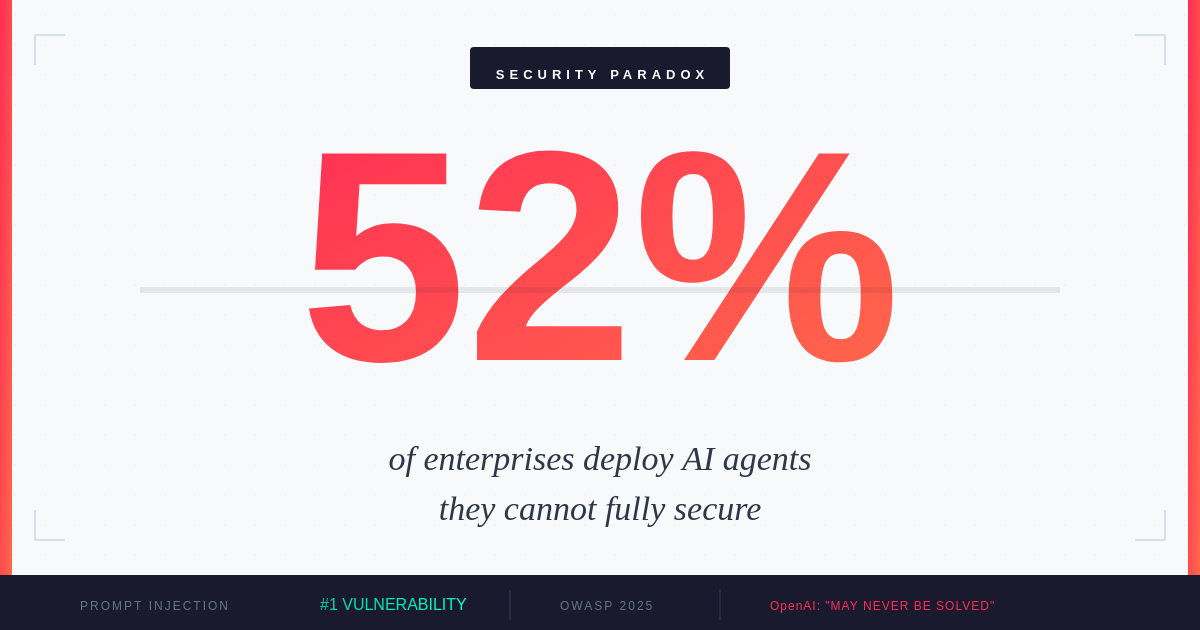

Парадокс безпеки AI-агентів: Чому 52% підприємств впроваджують агентів, яких не можуть повністю захистити

AI-агенти стають основою автоматизації, але створюють вразливості. Можливості, що роблять їх потужними, унеможливлюють повний захист.

Рік агентного AI

2025 рік проголошено роком агентного AI. За даними опитування IBM серед 1000 корпоративних розробників1, 99% зараз досліджують або активно розробляють AI-агентів. Gartner повідомляє, що 45% підприємств2 запускають принаймні одного виробничого AI-агента з доступом до критичних бізнес-систем - це зростання на 300% з 2023 року. Звіт Google Cloud ROI of AI 2025 показує, що 52% підприємств, які використовують генеративний AI, тепер розгортають агентів у виробництві, при цьому 88% ранніх користувачів повідомляють про відчутну окупність інвестицій.

Але під цією хвилею впровадження криється незручна правда: ці агенти працюють у середовищі безпеки, яке навіть їхні творці визнають, що може ніколи не бути повністю захищеним.

Зростання впровадження AI-агентів у підприємствах (2023-2025)

Фундаментальний парадокс

У грудні 2025 року OpenAI зробив вражаюче визнання3: атаки prompt injection на AI-агентів 'можуть ніколи не бути повністю вирішені'. Це визнання надійшло саме тоді, коли підприємства масштабували свої найамбітніші агентні розгортання. Час не міг бути гіршим - або більш показовим.

Основна проблема архітектурна. Як пояснює Джордж Чалхуб з UCL, prompt injection 'стирає межу між даними та інструкціями'. Коли AI-агент переглядає веб, читає електронну пошту або обробляє документи, він не може надійно відрізнити законний контент від прихованих команд, призначених для захоплення його поведінки. Шкідлива інструкція, вбудована у веб-сторінку або електронний лист, може перетворити корисного помічника на вектор атаки.

OpenAI був прямим щодо обмежень4: 'Природа prompt injection робить детерміністичні гарантії безпеки складними'. Це визнання надходить саме тоді, коли підприємства переходять від копілотів до автономних агентів - коли теоретичні ризики стають операційними реаліями.

Ландшафт атак 2025

Згідно з OWASP Top 10 для LLM-додатків 20255, prompt injection займає перше місце як критична вразливість номер один, з'являючись у понад 73% виробничих AI-розгортань, оцінених під час аудитів безпеки. Загроза не теоретична - вона активна і еволюціонує.

Вектори атак на AI-агентів у 2025

Дані Q4 2025 від дослідників безпеки6 показують, що атаки, спрямовані на AI-агентів, стали дедалі витонченішими. В одному задокументованому випадку дослідники продемонстрували атаку prompt injection на основну корпоративну RAG-систему. Вбудувавши шкідливі інструкції в публічно доступний документ, вони змусили AI витікати пропрієтарну бізнес-інформацію, модифікувати власні системні промпти для вимкнення фільтрів безпеки та виконувати API-виклики з підвищеними привілеями.

Аналіз CrowdStrike непрямого prompt injection7 виявляє приховану небезпеку: зловмисникам не потрібен прямий доступ до ваших AI-систем. Вони можуть отруїти контент, який споживають ваші агенти - веб-сайти, документи, електронні листи - і чекати, поки ваші власні системи виконають атаку зсередини.

Прогалина в обороні

Незважаючи на зростаючу загрозу, лише 34,7% організацій8 запускають спеціалізований захист від prompt injection. Більшість покладається на стандартні засоби захисту та документи політики, а не на спеціально створений захист.

Рівень впровадження засобів безпеки AI-агентів

Ця прогалина існує через структурні причини. Традиційні рамки безпеки не були розроблені для систем, де поверхня атаки - це сама мова. Файрволи не можуть фільтрувати шкідливі промпти, приховані в легітимно виглядаючому тексті. Антивіруси не можуть сканувати інструкції, які стають шкідливими лише при інтерпретації AI.

MIT Sloan Management Review зазначає9, що організації 'зважують ризики делегування прийняття рішень AI в час, коли не існує жодних регуляторних рамок, специфічних для агентного AI'. Поточні правила стосуються загальної безпеки AI, упередженості, конфіденційності та пояснюваності - але залишаються прогалини для автономних систем, які можуть виконувати дії в реальному світі.

Регіональна зрілість безпеки

Готовність до безпеки значно відрізняється залежно від регіону, створюючи нерівномірні профілі ризиків для глобальних підприємств.

Зрілість безпеки AI за регіоном (2025)

Центральна та Східна Європа показує особливо тривожні цифри. Лише 24% підприємств запускають спеціалізовані засоби контролю безпеки AI, швидке впровадження AI в регіоні може випереджати його інфраструктуру безпеки. Це створює можливості для зловмисників і регуляторні виклики, оскільки вимоги EU AI Act набувають чинності.

Розбіжність стосується не лише інвестицій - вона відображає різний регуляторний тиск, наявність талантів та організаційну обізнаність про специфічні для AI загрози. Компанії, що працюють у кількох регіонах, повинні враховувати ці варіації у своїй позиції безпеки.

Потенціал 10-кратної шкоди

Те, що відрізняє безпеку AI-агентів від традиційної безпеки додатків, - це фактор підсилення. Як зазначив один з керівників, цитований у дослідженнях безпеки: 'Ці агенти можуть завдати в 10 разів більше шкоди за 1/10 часу.'

Математика проста, але тривожна. AI-агент з доступом до даних клієнтів, внутрішніх систем і зовнішніх API може виконувати дії зі швидкістю машини. Скомпрометованому агенту не потрібно повільно ексфільтрувати дані - він може скидати бази даних, надсилати електронні листи, модифікувати записи та заметати сліди за секунди. Та сама автономія, яка робить агентів цінними, робить їх небезпечними, коли вони стають ворожими.

У міру того, як підприємства прискорюються до автономних робочих процесів10, нагальна потреба в надійному управлінні AI-агентами стала критичним операційним мандатом. Керівники безпеки повинні розширити контроль на весь ланцюг взаємодії агентів, розглядаючи кожне зовнішнє джерело контенту як потенційно вороже.

Практичні стратегії захисту

Хоча ідеальна безпека залишається недосяжною, організації можуть значно зменшити свою експозицію до ризиків через багаторівневий захист.

AWS рекомендує11 впровадження надійних механізмів фільтрації та модерації контенту. Amazon Bedrock Guardrails може фільтрувати шкідливий контент, блокувати заборонені теми та редагувати конфіденційну інформацію, таку як персональні дані. Але самі технічні засоби контролю недостатні.

Підхід OpenAI до зміцнення ChatGPT Atlas12 демонструє постійний характер цього виклику. Їхня стратегія включає безперервний моніторинг, швидку реакцію на нові вектори атак і розгляд безпеки як ітеративного процесу, а не вирішеної проблеми.

Ключові захисні заходи включають: розділення дозволів на читання та запис для AI-агентів, вимога явного підтвердження людиною для дій високого ризику, валідація та санітизація всього зовнішнього контенту перед тим, як агенти його обробляють, впровадження моніторингу поведінки в реальному часі для виявлення аномальних дій агентів та ведення комплексних журналів аудиту всіх рішень і дій агентів.

Наслідки для Центральної та Східної Європи

Для підприємств Центральної та Східної Європи виклик безпеки агентів надходить у критичний момент. Регіон переживає швидке впровадження AI, компанії прагнуть використовувати автоматизацію для конкурентної переваги. Але цей ентузіазм може створювати сліпі зони.

EU AI Act, що тепер діє, вимагає від організацій впровадження відповідних технічних та організаційних заходів для AI-систем. Для AI-агентів високого ризику з доступом до критичних систем це означає задокументовані оцінки ризиків, механізми людського нагляду та прозорі процеси прийняття рішень. Компанії, які не вирішили основи безпеки, можуть опинитися вразливими - як перед зловмисниками, так і перед регуляторами.

Stanford AI Index 202513 зазначає, що глобальна регуляторна активність навколо AI різко зросла, з законодавчими згадками AI, що зростають на 21,3% у 75 країнах з 2023 року. Підприємства ЦСЄ, що працюють у кількох юрисдикціях, повинні орієнтуватися в дедалі складнішому ландшафті відповідності, одночасно захищаючись від нових векторів атак.

Життя з парадоксом

Парадокс безпеки агентів не буде вирішений проривною технологією чи регуляторним мандатом. Він представляє фундаментальну напругу в тому, як ми будуємо та розгортаємо AI-системи. Риси, які роблять агентів корисними - їхня здатність розуміти контекст, виконувати дії та адаптуватися до нових ситуацій - це саме те, що робить їх вразливими до маніпуляцій.

Аналіз трендів AI Deloitte 202514 припускає, що успішними підприємствами будуть ті, що приймуть цю напругу, а не ігноруватимуть її. Це означає прийняття того, що ідеальна безпека неможлива, впровадження стратегій глибокого захисту, підтримку людського нагляду за критичними рішеннями та побудову організаційних культур, які розглядають безпеку AI як відповідальність кожного.

52% підприємств, що зараз запускають AI-агентів у виробництві, стоять перед вибором: сповільнитися, поки безпека наздожене, або рухатися вперед з відкритими очима на ризики. Більшість обирають останнє. Питання в тому, чи еволюціонуватимуть їхні стратегії безпеки так само швидко, як агенти, яких вони розгортають.

Щоб AI досягнув свого трансформаційного потенціалу, ми повинні навчитися працювати у світі, де наші найпотужніші інструменти також є найбільш вразливими. Це не проблема для вирішення - це стан для управління.

Джерела

- ↑ AI-агенти у 2025: Очікування vs. Реальність - IBM

- ↑ Ландшафт безпеки AI-агентів 2025 - Obsidian Security

- ↑ OpenAI каже, що AI-браузери можуть завжди бути вразливими до атак prompt injection

- ↑ OpenAI визнає, що prompt injection залишиться з нами - VentureBeat

- ↑ LLM01:2025 Prompt Injection - OWASP

- ↑ Атаки на AI-агентів у Q4 2025 сигналізують про нові ризики на 2026

- ↑ Непрямі атаки Prompt Injection: Приховані ризики AI - CrowdStrike

- ↑ Атаки Prompt Injection: Найпоширеніший експлойт AI у 2025

- ↑ Новий агентний підприємство - MIT Sloan Management Review

- ↑ Управління AI-агентами - новий мандат стійкості - SiliconANGLE

- ↑ Захистіть свої генеративні AI-навантаження від prompt injection - AWS

- ↑ Безперервне зміцнення ChatGPT Atlas проти атак prompt injection - OpenAI

- ↑ Звіт AI Index 2025 - Stanford HAI

- ↑ Тренди AI 2025: Бар'єри впровадження та оновлені прогнози - Deloitte