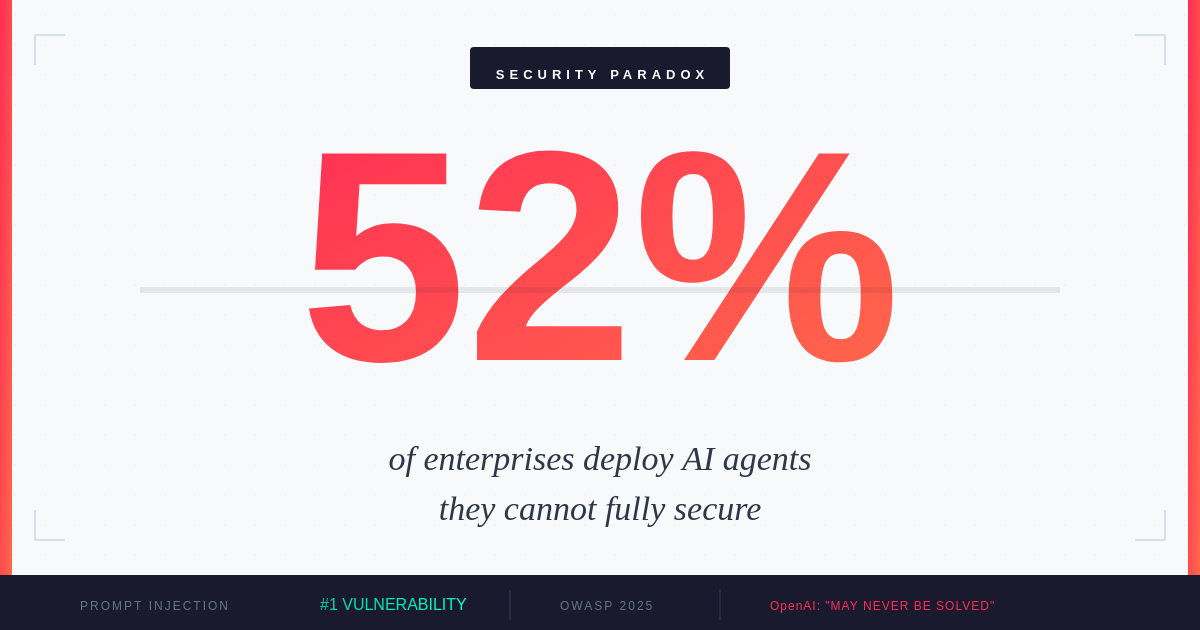

Das agentische Sicherheitsparadoxon: Warum 52% der Unternehmen KI-Agenten einsetzen, die sie nicht vollstaendig absichern koennen

Waehrend KI-Agenten zum Rueckgrat der Unternehmensautomatisierung werden, entsteht eine kritische Schwachstelle - genau die Faehigkeiten, die sie maechtig machen, machen sie auch unmoeglich vollstaendig zu schuetzen. OpenAI gibt zu, dass Prompt-Injection moeglicherweise nie geloest werden kann.

Das Jahr der agentischen KI

2025 wurde zum Jahr der agentischen KI erklaert. Laut IBMs Umfrage unter 1.000 Unternehmensentwicklern1 erforschen oder entwickeln 99% aktiv KI-Agenten. Gartner berichtet, dass 45% der Unternehmen2 mindestens einen produktiven KI-Agenten mit Zugang zu kritischen Geschaeftssystemen betreiben - ein Anstieg von 300% seit 2023. Der ROI of AI 2025 Report von Google Cloud zeigt, dass 52% der Unternehmen, die generative KI nutzen, jetzt Agenten in der Produktion einsetzen, wobei 88% der fruehen Anwender greifbaren ROI berichten.

Aber unter diesem Adoptionsschub verbirgt sich eine unbequeme Wahrheit: Diese Agenten operieren in einer Sicherheitslandschaft, von der selbst ihre Schoepfer zugeben, dass sie moeglicherweise nie vollstaendig gesichert werden kann.

Wachstum der KI-Agenten-Bereitstellung in Unternehmen (2023-2025)

Das fundamentale Paradoxon

Im Dezember 2025 machte OpenAI ein ueberraschendes Eingestaendnis3: Prompt-Injection-Angriffe auf KI-Agenten 'werden moeglicherweise nie vollstaendig geloest.' Dieses Eingestaendnis kam genau dann, als Unternehmen ihre ambitioniertesten agentischen Bereitstellungen skalierten. Das Timing haette nicht schlechter sein koennen - oder aufschlussreicher.

Das Kernproblem ist architektonisch. Wie George Chalhoub von UCL erklaert, 'verwischt Prompt-Injection die Grenze zwischen Daten und Anweisungen.' Wenn ein KI-Agent im Web surft, E-Mails liest oder Dokumente verarbeitet, kann er nicht zuverlaessig zwischen legitimem Inhalt und versteckten Befehlen unterscheiden, die sein Verhalten kapern sollen. Eine boesartige Anweisung, die in einer Webseite oder E-Mail eingebettet ist, kann einen hilfreichen Assistenten in einen Angriffsvektor verwandeln.

OpenAI war direkt bezueglich der Grenzen4: 'Die Natur der Prompt-Injection macht deterministische Sicherheitsgarantien herausfordernd.' Dieses Eingestaendnis kommt genau dann, wenn Unternehmen von Copiloten zu autonomen Agenten wechseln - wenn theoretische Risiken zu operativen Realitaeten werden.

Die Angriffslandschaft 2025

Laut OWASPs Top 10 fuer LLM-Anwendungen 20255 rangiert Prompt-Injection als die kritischste Schwachstelle Nummer eins und erscheint in ueber 73% der produktiven KI-Bereitstellungen, die bei Sicherheitsaudits bewertet wurden. Die Bedrohung ist nicht theoretisch - sie ist aktiv und entwickelt sich weiter.

KI-Agenten-Angriffsvektoren 2025

Q4 2025-Daten von Sicherheitsforschern6 zeigen, dass Angriffe auf KI-Agenten zunehmend ausgefeilter geworden sind. In einem dokumentierten Fall demonstrierten Forscher einen Prompt-Injection-Angriff auf ein grosses Unternehmens-RAG-System. Durch das Einbetten boesartiger Anweisungen in ein oeffentlich zugaengliches Dokument veranlassten sie die KI, proprietaere Geschaeftsinformationen preiszugeben, ihre eigenen System-Prompts zu aendern, um Sicherheitsfilter zu deaktivieren, und API-Aufrufe mit erhoehten Rechten auszufuehren.

CrowdStrikes Analyse der indirekten Prompt-Injection7 enthuellt die versteckte Gefahr: Angreifer brauchen keinen direkten Zugang zu Ihren KI-Systemen. Sie koennen die Inhalte vergiften, die Ihre Agenten konsumieren - Websites, Dokumente, E-Mails - und warten, bis Ihre eigenen Systeme den Angriff von innen ausfuehren.

Die Verteidigungsluecke

Trotz der eskalierenden Bedrohung betreiben nur 34,7% der Organisationen8 dedizierte Abwehrmassnahmen gegen Prompt-Injection. Die Mehrheit verlaesst sich auf Standardsicherungen und Richtliniendokumente statt auf zweckgebundene Schutzmassnahmen.

Adoptionsrate von KI-Agenten-Sicherheitskontrollen

Diese Luecke besteht aus strukturellen Gruenden. Traditionelle Sicherheitsrahmen wurden nicht fuer Systeme entwickelt, bei denen die Angriffsflaeche die Sprache selbst ist. Firewalls koennen keine boesartigen Prompts filtern, die in legitim aussehenden Texten versteckt sind. Antivirenprogramme koennen keine Anweisungen scannen, die erst schaedlich werden, wenn sie von einer KI interpretiert werden.

MIT Sloan Management Review stellt fest9, dass Organisationen 'die Risiken der Delegation von Entscheidungen an KI abwaegen, zu einer Zeit, in der keine regulatorischen Rahmenwerke speziell fuer agentische KI existieren.' Aktuelle Regeln behandeln allgemeine KI-Sicherheit, Voreingenommenheit, Datenschutz und Erklaerbarkeit - aber Luecken bleiben fuer autonome Systeme, die reale Aktionen ausfuehren koennen.

Regionale Sicherheitsreife

Die Sicherheitsbereitschaft variiert erheblich nach Region und schafft ungleiche Risikoprofile fuer globale Unternehmen.

KI-Sicherheitsreife nach Region (2025)

Mittel- und Osteuropa zeigt besonders besorgniserregende Zahlen. Mit nur 24% der Unternehmen, die dedizierte KI-Sicherheitskontrollen betreiben, koennte die schnelle KI-Adoption der Region ihre Sicherheitsinfrastruktur ueberholen. Dies schafft Moeglichkeiten fuer Angreifer und regulatorische Herausforderungen, wenn die Anforderungen des EU AI Act in Kraft treten.

Die Disparitaet betrifft nicht nur Investitionen - sie spiegelt unterschiedliche regulatorische Druecke, Talentverfuegbarkeit und organisatorisches Bewusstsein fuer KI-spezifische Bedrohungen wider. Unternehmen, die regionenuebergreifend taetig sind, muessen diese Variationen in ihrer Sicherheitshaltung beruecksichtigen.

Das 10-fache Schadenspotenzial

Was die Sicherheit von KI-Agenten von traditioneller Anwendungssicherheit unterscheidet, ist der Verstaerkungsfaktor. Wie ein in Sicherheitsforschung zitierter Fuehrungskraft bemerkte: 'Diese Agenten koennen 10-mal mehr Schaden in 1/10 der Zeit anrichten.'

Die Mathematik ist einfach, aber alarmierend. Ein KI-Agent mit Zugang zu Kundendaten, internen Systemen und externen APIs kann Aktionen mit Maschinengeschwindigkeit ausfuehren. Ein kompromittierter Agent muss Daten nicht langsam exfiltrieren - er kann Datenbanken dumpen, E-Mails senden, Datensaetze aendern und seine Spuren in Sekunden verwischen. Dieselbe Autonomie, die Agenten wertvoll macht, macht sie gefaehrlich, wenn sie feindlich uebernommen werden.

Waehrend Unternehmen auf autonome Workflows beschleunigen10, ist der dringende Bedarf an robuster KI-Agenten-Governance zu einem kritischen operativen Mandat geworden. Sicherheitsverantwortliche muessen Kontrollen ueber die gesamte Agenten-Interaktionskette erweitern und jede externe Inhaltsquelle als potenziell feindlich behandeln.

Praktische Verteidigungsstrategien

Waehrend perfekte Sicherheit schwer fassbar bleibt, koennen Organisationen ihre Risikoexposition durch geschichtete Verteidigungen erheblich reduzieren.

AWS empfiehlt11 die Implementierung robuster Inhaltsfilterungs- und Moderationsmechanismen. Amazon Bedrock Guardrails kann schaedliche Inhalte filtern, verbotene Themen blockieren und sensible Informationen wie personenbezogene Daten redigieren. Aber technische Kontrollen allein reichen nicht aus.

OpenAIs Ansatz zur Haertung von ChatGPT Atlas12 demonstriert die fortlaufende Natur dieser Herausforderung. Ihre Strategie umfasst kontinuierliche Ueberwachung, schnelle Reaktion auf neue Angriffsvektoren und die Behandlung von Sicherheit als iterativen Prozess statt als geloestes Problem.

Wichtige Verteidigungsmassnahmen umfassen: Trennung von Lese- und Schreibberechtigungen fuer KI-Agenten, Erfordernis expliziter menschlicher Bestaetigung fuer risikoreiche Aktionen, Validierung und Bereinigung aller externen Inhalte, bevor Agenten sie aufnehmen, Implementierung von Echtzeit-Verhaltensueberwachung zur Erkennung anomaler Agentenaktionen und Fuehrung umfassender Audit-Logs aller Agentenentscheidungen und -aktionen.

Implikationen fuer Mittel- und Osteuropa

Fuer Unternehmen in Mittel- und Osteuropa kommt die agentische Sicherheitsherausforderung zu einem kritischen Zeitpunkt. Die Region erlebt eine schnelle KI-Adoption, wobei Unternehmen begierig sind, Automatisierung fuer Wettbewerbsvorteile zu nutzen. Aber dieser Enthusiasmus koennte blinde Flecken schaffen.

Der EU AI Act, jetzt in Kraft, verlangt von Organisationen die Implementierung angemessener technischer und organisatorischer Massnahmen fuer KI-Systeme. Fuer Hochrisiko-KI-Agenten mit Zugang zu kritischen Systemen bedeutet dies dokumentierte Risikobewertungen, menschliche Aufsichtsmechanismen und transparente Entscheidungsprozesse. Unternehmen, die die Sicherheitsgrundlagen nicht adressiert haben, koennten exponiert sein - sowohl gegenueber Angreifern als auch gegenueber Regulierungsbehoerden.

Der Stanford AI Index 202513 stellt fest, dass die globale regulatorische Aktivitaet rund um KI dramatisch zugenommen hat, mit einem Anstieg der legislativen Erwaehnungen von KI um 21,3% in 75 Laendern seit 2023. MOE-Unternehmen, die in mehreren Jurisdiktionen taetig sind, muessen eine zunehmend komplexe Compliance-Landschaft navigieren und sich gleichzeitig gegen neuartige Angriffsvektoren verteidigen.

Leben mit dem Paradoxon

Das agentische Sicherheitsparadoxon wird nicht durch eine bahnbrechende Technologie oder ein regulatorisches Mandat geloest werden. Es repraesentiert eine fundamentale Spannung in der Art, wie wir KI-Systeme bauen und bereitstellen. Die Eigenschaften, die Agenten nuetzlich machen - ihre Faehigkeit, Kontext zu verstehen, Aktionen auszufuehren und sich an neue Situationen anzupassen - sind genau das, was sie anfaellig fuer Manipulation macht.

Deloittes KI-Trendanalyse 202514 legt nahe, dass erfolgreiche Unternehmen diejenigen sein werden, die diese Spannung annehmen, anstatt sie zu ignorieren. Dies bedeutet zu akzeptieren, dass perfekte Sicherheit unmoeglich ist, Defense-in-Depth-Strategien zu implementieren, menschliche Aufsicht fuer kritische Entscheidungen aufrechtzuerhalten und Organisationskulturen aufzubauen, die KI-Sicherheit als Verantwortung aller behandeln.

Die 52% der Unternehmen, die jetzt KI-Agenten in der Produktion betreiben, stehen vor einer Wahl: verlangsamen, bis die Sicherheit aufholt, oder mit offenen Augen fuer die Risiken vorwaertsgehen. Die meisten waehlen Letzteres. Die Frage ist, ob ihre Sicherheitsstrategien so schnell evolvieren werden wie die Agenten, die sie bereitstellen.

Damit KI ihr transformatives Potenzial erreichen kann, muessen wir lernen, in einer Welt zu operieren, in der unsere maechtigsten Werkzeuge auch unsere verwundbarsten sind. Das ist kein Problem zu loesen - es ist ein Zustand zu managen.

Quellen

- ↑ KI-Agenten 2025: Erwartungen vs. Realität - IBM

- ↑ Die KI-Agenten-Sicherheitslandschaft 2025 - Obsidian Security

- ↑ OpenAI sagt, KI-Browser könnten immer anfällig für Prompt-Injection-Angriffe sein

- ↑ OpenAI gibt zu, dass Prompt-Injection bleiben wird - VentureBeat

- ↑ LLM01:2025 Prompt Injection - OWASP

- ↑ KI-Agenten-Angriffe in Q4 2025 signalisieren neue Risiken für 2026

- ↑ Indirekte Prompt-Injection-Angriffe: Versteckte KI-Risiken - CrowdStrike

- ↑ Prompt-Injection-Angriffe: Der häufigste KI-Exploit im Jahr 2025

- ↑ Das aufkommende agentische Unternehmen - MIT Sloan Management Review

- ↑ KI-Agenten-Governance ist das neue Resilienz-Mandat - SiliconANGLE

- ↑ Schützen Sie Ihre generativen KI-Workloads vor Prompt-Injections - AWS

- ↑ Kontinuierliche Härtung von ChatGPT Atlas gegen Prompt-Injection-Angriffe - OpenAI

- ↑ Der AI Index Report 2025 - Stanford HAI

- ↑ KI-Trends 2025: Adoptionsbarrieren und aktualisierte Prognosen - Deloitte