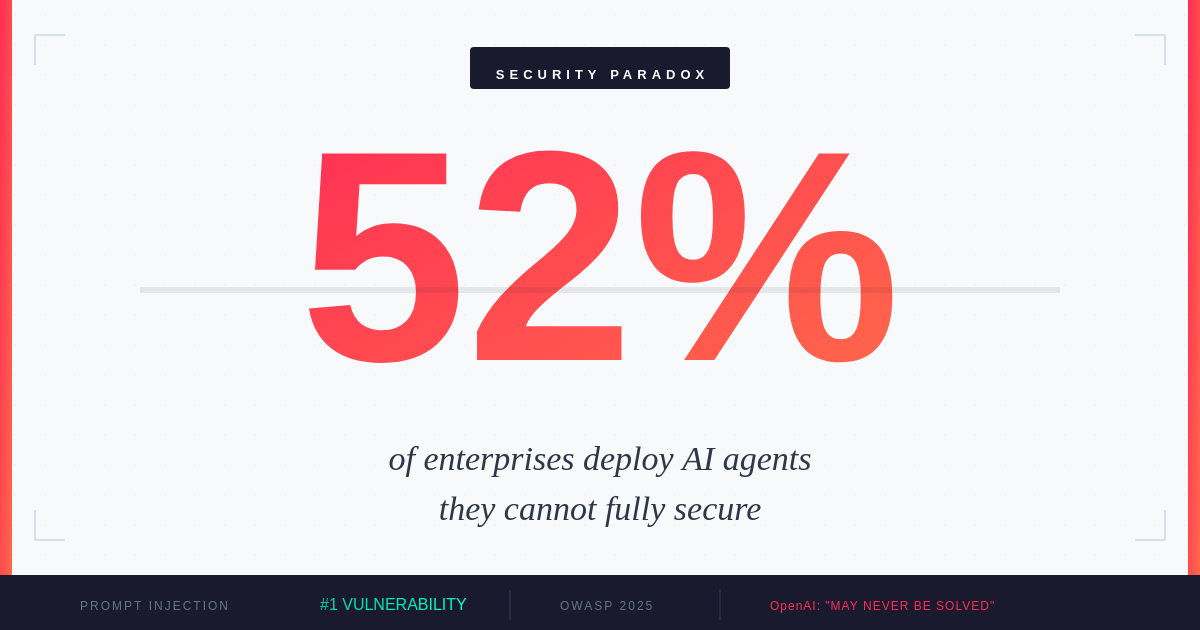

Paradoks bezpieczenstwa agentow AI: Dlaczego 52% przedsiebiorstw wdraza agentow, ktorych nie moze w pelni zabezpieczyc

Agenci AI napedzaja automatyzacje, ale tworza luki bezpieczenstwa. Mozliwosci, ktore czynia ich poteznym, uniemozliwiaja pelne zabezpieczenie.

Rok agentycznej AI

Rok 2025 zostal ogloszony rokiem agentycznej AI. Wedlug badania IBM przeprowadzonego wsrod 1000 deweloperow korporacyjnych1, 99% z nich bada lub aktywnie rozwija agentow AI. Gartner podaje, ze 45% przedsiebiorstw2 uruchamia co najmniej jednego produkcyjnego agenta AI z dostepem do krytycznych systemow biznesowych - to wzrost o 300% od 2023 roku. Raport ROI of AI 2025 od Google Cloud ujawnia, ze 52% przedsiebiorstw korzystajacych z generatywnej AI wdraza teraz agentow w produkcji, a 88% wczesnych uzytkownikow raportuje wymierny zwrot z inwestycji.

Ale pod ta fala adopcji kryje sie niewygodna prawda: ci agenci dzialaja w srodowisku bezpieczenstwa, ktore nawet ich tworcy przyznaja, ze moze nigdy nie byc w pelni zabezpieczone.

Wzrost wdrożeń agentów AI w przedsiębiorstwach (2023-2025)

Fundamentalny paradoks

W grudniu 2025 roku OpenAI zlozylo zaskakujace przyznanie3: ataki prompt injection na agentow AI 'moga nigdy nie zostac w pelni rozwiazane'. To przyznanie nadeszlo dokladnie wtedy, gdy przedsiebiorstwa skalowaly swoje najbardziej ambitne wdrozenia agentow. Czas nie mogl byc gorszy - ani bardziej wymowny.

Glowny problem jest architektoniczny. Jak wyjasnia George Chalhoub z UCL, prompt injection 'zaciera granice miedzy danymi a instrukcjami'. Gdy agent AI przeglada siec, czyta e-maile lub przetwarza dokumenty, nie moze niezawodnie rozroznic miedzy uzasadniona trescia a ukrytymi poleceniami zaprojektowanymi do przejecia jego zachowania. Zlosliwa instrukcja osadzona na stronie internetowej lub w e-mailu moze zamienic pomocnego asystenta w wektor ataku.

OpenAI bylo bezposrednie co do ograniczen4: 'Natura prompt injection sprawia, ze deterministyczne gwarancje bezpieczenstwa sa trudne.' To przyznanie nadchodzi dokladnie wtedy, gdy przedsiebiorstwa przechodza od kopilotow do autonomicznych agentow - gdy teoretyczne ryzyka staja sie realiami operacyjnymi.

Krajobraz atakow w 2025

Wedlug OWASP Top 10 dla aplikacji LLM 20255, prompt injection zajmuje pierwsze miejsce jako krytyczna podatnosc, pojawiajac sie w ponad 73% produkcyjnych wdrozen AI ocenianych podczas audytow bezpieczenstwa. Zagrozenie nie jest teoretyczne - jest aktywne i ewoluuje.

Wektory ataków na agentów AI w 2025

Dane z Q4 2025 od badaczy bezpieczenstwa6 pokazuja, ze ataki wymierzone w agentow AI staly sie coraz bardziej wyrafinowane. W jednym udokumentowanym przypadku badacze zademonstrowali atak prompt injection na glowny korporacyjny system RAG. Osadzajac zlosliwe instrukcje w publicznie dostepnym dokumencie, spowodowali, ze AI wycieklo wlasnosc intelektualna firmy, zmodyfikowalo swoje wlasne prompty systemowe, aby wylaczyc filtry bezpieczenstwa, i wykonalo wywolania API z podwyzszonymi uprawnieniami.

Analiza CrowdStrike dotyczaca posredniego prompt injection7 ujawnia ukryte niebezpieczenstwo: atakujacy nie potrzebuja bezposredniego dostepu do Twoich systemow AI. Moga zatruic tresci, ktore Twoi agenci konsumuja - strony internetowe, dokumenty, e-maile - i czekac, az Twoje wlasne systemy wykonaja atak od srodka.

Luka w obronie

Pomimo eskalujacego zagrozenia, tylko 34,7% organizacji8 uruchamia dedykowane zabezpieczenia przed prompt injection. Wiekszosc polega na domyslnych zabezpieczeniach i dokumentach polityki, a nie na specjalnie zbudowanych ochronach.

Wskaźnik adopcji kontroli bezpieczeństwa agentów AI

Ta luka istnieje z powodow strukturalnych. Tradycyjne ramy bezpieczenstwa nie zostaly zaprojektowane dla systemow, gdzie powierzchnia ataku to sam jezyk. Zapory sieciowe nie moga filtrowac zlosliwych promptow ukrytych w legitymacyjnie wygladajacym tekscie. Programy antywirusowe nie moga skanowac instrukcji, ktore staja sie szkodliwe dopiero po interpretacji przez AI.

MIT Sloan Management Review zauwaza9, ze organizacje 'rozwazaja ryzyko delegowania podejmowania decyzji do AI w czasie, gdy nie istnieja zadne ramy regulacyjne specyficzne dla agentycznej AI'. Obecne przepisy dotycza ogolnego bezpieczenstwa AI, stronniczosci, prywatnosci i wyjastnialnosci - ale pozostaja luki dla autonomicznych systemow, ktore moga podejmowac dzialania w rzeczywistym swiecie.

Regionalna dojrzalosc bezpieczenstwa

Gotowosc bezpieczenstwa znacznie sie rozni w zaleznosci od regionu, tworzac nierowne profile ryzyka dla globalnych przedsiebiorstw.

Dojrzałość bezpieczeństwa AI według regionu (2025)

Europa Srodkowo-Wschodnia wykazuje szczegolnie niepokojace liczby. Przy zaledwie 24% przedsiebiorstw uruchamiajacych dedykowane kontrole bezpieczenstwa AI, szybka adopcja AI w regionie moze wyprzedzac jego infrastrukture bezpieczenstwa. Stwarza to mozliwosci dla atakujacych i wyzwania regulacyjne w miare wchodzenia w zycie wymagan Aktu AI UE.

Roznica nie dotyczy tylko inwestycji - odzwierciedla rozne presje regulacyjne, dostepnosc talentow i swiadomosc organizacyjna zagrozen specyficznych dla AI. Firmy dzialajace w wielu regionach musza uwzgledniac te roznice w swojej postawie bezpieczenstwa.

Potencjal 10-krotnych szkod

To, co odroznia bezpieczenstwo agentow AI od tradycyjnego bezpieczenstwa aplikacji, to czynnik wzmocnienia. Jak zauwazyl jeden z dyrektorow cytowanych w badaniach bezpieczenstwa: 'Ci agenci moga wyrzadzic 10 razy wiecej szkod w 1/10 czasu.'

Matematyka jest prosta, ale alarmujaca. Agent AI z dostepem do danych klientow, systemow wewnetrznych i zewnetrznych API moze wykonywac dzialania z szybkoscia maszyny. Skompromitowany agent nie musi powoli eksfiltrowac danych - moze zrzucic bazy danych, wyslac e-maile, modyfikowac rekordy i zacierac slady w ciagu sekund. Ta sama autonomia, ktora czyni agentow wartosciowymi, czyni ich niebezpiecznymi, gdy zostana wrogo przejeci.

W miare jak przedsiebiorstwa przyspieszaja w kierunku autonomicznych przeplywow pracy10, pilna potrzeba solidnego zarzadzania agentami AI stala sie krytycznym mandatem operacyjnym. Liderzy bezpieczenstwa musza rozszerzyc kontrole na caly lancuch interakcji agentow, traktujac kazde zewnetrzne zrodlo tresci jako potencjalnie wrogie.

Praktyczne strategie obronne

Chociaz idealne bezpieczenstwo pozostaje nieuchwytne, organizacje moga znacznie zmniejszyc swoja ekspozycje na ryzyko poprzez warstwowe zabezpieczenia.

AWS zaleca11 wdrozenie solidnych mechanizmow filtrowania i moderacji tresci. Amazon Bedrock Guardrails moze filtrowac szkodliwe tresci, blokowac zabronione tematy i redagowac wrazliwe informacje, takie jak dane osobowe. Ale same kontrole techniczne nie wystarczaja.

Podejscie OpenAI do wzmacniania ChatGPT Atlas12 demonstruje ciagly charakter tego wyzwania. Ich strategia obejmuje ciagly monitoring, szybka reakcje na nowe wektory atakow i traktowanie bezpieczenstwa jako procesu iteracyjnego, a nie rozwiazanego problemu.

Kluczowe srodki obronne obejmuja: oddzielenie uprawnien do odczytu i zapisu dla agentow AI, wymaganie wyraznego potwierdzenia przez czlowieka dla dzialań wysokiego ryzyka, walidacje i sanityzacje wszystkich zewnetrznych tresci przed ich przetworzeniem przez agentow, wdrozenie monitorowania behawioralnego w czasie rzeczywistym w celu wykrywania anomalnych dzialań agentow oraz utrzymywanie kompleksowych dziennikow audytu wszystkich decyzji i dzialań agentow.

Implikacje dla Europy Srodkowo-Wschodniej

Dla przedsiebiorstw w Europie Srodkowo-Wschodniej wyzwanie bezpieczenstwa agentycznego pojawia sie w krytycznym momencie. Region doswiadcza szybkiej adopcji AI, z firmami chetnie wykorzystujacymi automatyzacje dla przewagi konkurencyjnej. Ale ten entuzjazm moze tworzyc martwe punkty.

Akt AI UE, teraz obowiazujacy, wymaga od organizacji wdrozenia odpowiednich srodkow technicznych i organizacyjnych dla systemow AI. Dla agentow AI wysokiego ryzyka z dostepem do krytycznych systemow oznacza to udokumentowane oceny ryzyka, mechanizmy nadzoru ludzkiego i przejrzyste procesy decyzyjne. Firmy, ktore nie zajely sie podstawami bezpieczenstwa, moga byc narazone - zarowno na atakujacych, jak i na regulatorow.

Stanford AI Index 202513 zauwaza, ze globalna aktywnosc regulacyjna wokol AI dramatycznie wzrosla, ze wzmiankami legislacyjnymi o AI rosnacymi o 21,3% w 75 krajach od 2023 roku. Przedsiebiorstwa z Europy Srodkowo-Wschodniej dzialajace w wielu jurysdykcjach musza nawigowac w coraz bardziej zlozoonym krajobrazie zgodnosci, jednoczesnie broniac sie przed nowymi wektorami atakow.

Zycie z paradoksem

Paradoks bezpieczenstwa agentycznego nie zostanie rozwiazany przez przelomowa technologie ani mandat regulacyjny. Reprezentuje on fundamentalne napiecie w sposobie budowania i wdrazania systemow AI. Cechy, ktore czynia agentow uzytecznymi - ich zdolnosc do rozumienia kontekstu, podejmowania dzialań i adaptacji do nowych sytuacji - sa dokladnie tym, co czyni ich podatnymi na manipulacje.

Analiza trendow AI Deloitte 202514 sugeruje, ze odnoszące sukcesy przedsiebiorstwa beda tymi, ktore przyjma to napiecie, zamiast je ignorowac. Oznacza to akceptacje, ze idealne bezpieczenstwo jest niemozliwe, wdrazanie strategii obrony w glàb, utrzymywanie nadzoru ludzkiego nad krytycznymi decyzjami i budowanie kultur organizacyjnych, ktore traktuja bezpieczenstwo AI jako odpowiedzialnosc wszystkich.

52% przedsiebiorstw uruchamiajacych teraz agentow AI w produkcji stoi przed wyborem: zwolnic do czasu, az bezpieczenstwo nadrobi zaleglosci, lub isc naprzod ze swiadomoscia ryzyk. Wiekszosc wybiera to drugie. Pytanie brzmi, czy ich strategie bezpieczenstwa beda ewoluowac tak szybko, jak agenci, ktorych wdrazaja.

Aby AI osiagnelo swoj transformacyjny potencjal, musimy nauczyc sie dzialac w swiecie, w ktorym nasze najpotezniejsze narzedzia sa takze najbardziej podatne. To nie jest problem do rozwiazania - to stan do zarzadzania.

Zrodla

- ↑ Agenci AI w 2025: Oczekiwania vs. Rzeczywistość - IBM

- ↑ Krajobraz bezpieczeństwa agentów AI w 2025 - Obsidian Security

- ↑ OpenAI twierdzi, że przeglądarki AI mogą zawsze być podatne na ataki prompt injection

- ↑ OpenAI przyznaje, że prompt injection zostanie z nami - VentureBeat

- ↑ LLM01:2025 Prompt Injection - OWASP

- ↑ Ataki na agentów AI w Q4 2025 sygnalizują nowe ryzyka na 2026

- ↑ Pośrednie ataki Prompt Injection: Ukryte ryzyka AI - CrowdStrike

- ↑ Ataki Prompt Injection: Najczęstszy exploit AI w 2025

- ↑ Powstająca Agentyczna Firma - MIT Sloan Management Review

- ↑ Zarządzanie agentami AI to nowy mandat odporności - SiliconANGLE

- ↑ Zabezpiecz swoje obciążenia generatywnego AI przed prompt injection - AWS

- ↑ Ciągłe wzmacnianie ChatGPT Atlas przeciwko atakom prompt injection - OpenAI

- ↑ Raport AI Index 2025 - Stanford HAI

- ↑ Trendy AI 2025: Bariery adopcji i zaktualizowane prognozy - Deloitte